Balanceo de Grupos entre Sujetos y Configuración de Variables

¿Cómo puedes configurar una porción de participantes para que vean la versión X mientras que el resto ve la versión Y?

Para la aleatorización entre sujetos, hay algunas formas de implementar esto en Labvanced.

Existen dos enfoques / escenarios generales y el mejor, como siempre, depende de los detalles y el diseño particular de tu estudio.

ESCENARIO 1: Tareas y Grupos Independientes

Grado de Diferencia entre grupos: Hay una diferencia relativamente grande entre los grupos de participantes, es decir, las diferencias son vastas y abarcan múltiples marcos, objetos o eventos.

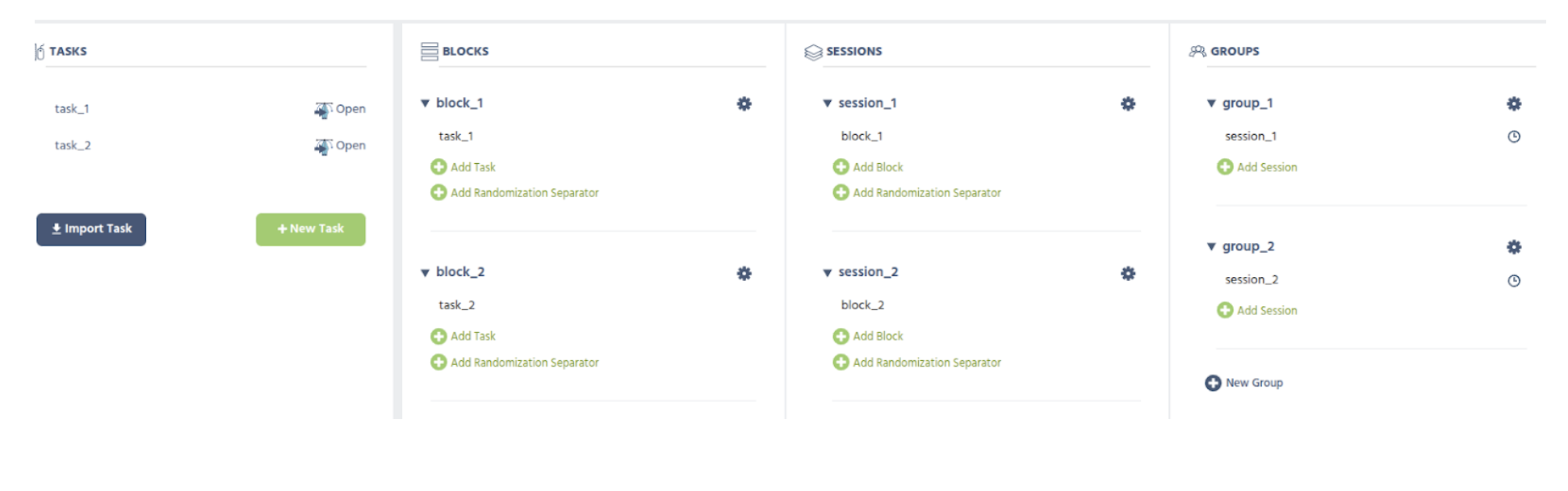

Configuración Sugerida: Crea dos (o cuántos necesites) grupos de sujetos y asigna las diferentes tareas a los diferentes grupos. En la imagen a continuación, se muestra un diseño de estudio simplificado que representa esta idea - donde la mitad de los sujetos (en el Grupo 1) harían

task_1, la otra mitad (en el Grupo 2) haríatask_2.Compensación: Ten en cuenta que la desventaja de este enfoque es que tienes tareas realmente separadas e independientes, lo que requiere que te ocupes de todo dos veces, es decir, un nuevo cambio que necesita estar en ambos grupos debe implementarse en ambas tareas por separado. Por esta razón, esta es solo una buena opción si la diferencia es bastante grande y, por lo tanto, es mejor tener dos+ implementaciones completamente separadas.

ESCENARIO 2: Variables Factoriales

Grado de Diferencia: La diferencia entre los grupos de participantes es bastante pequeña, es decir, algún "detalle" (por ejemplo, un objeto es visible o no / cuál imagen se muestra) dentro de una estructura de tarea de lo contrario similar.

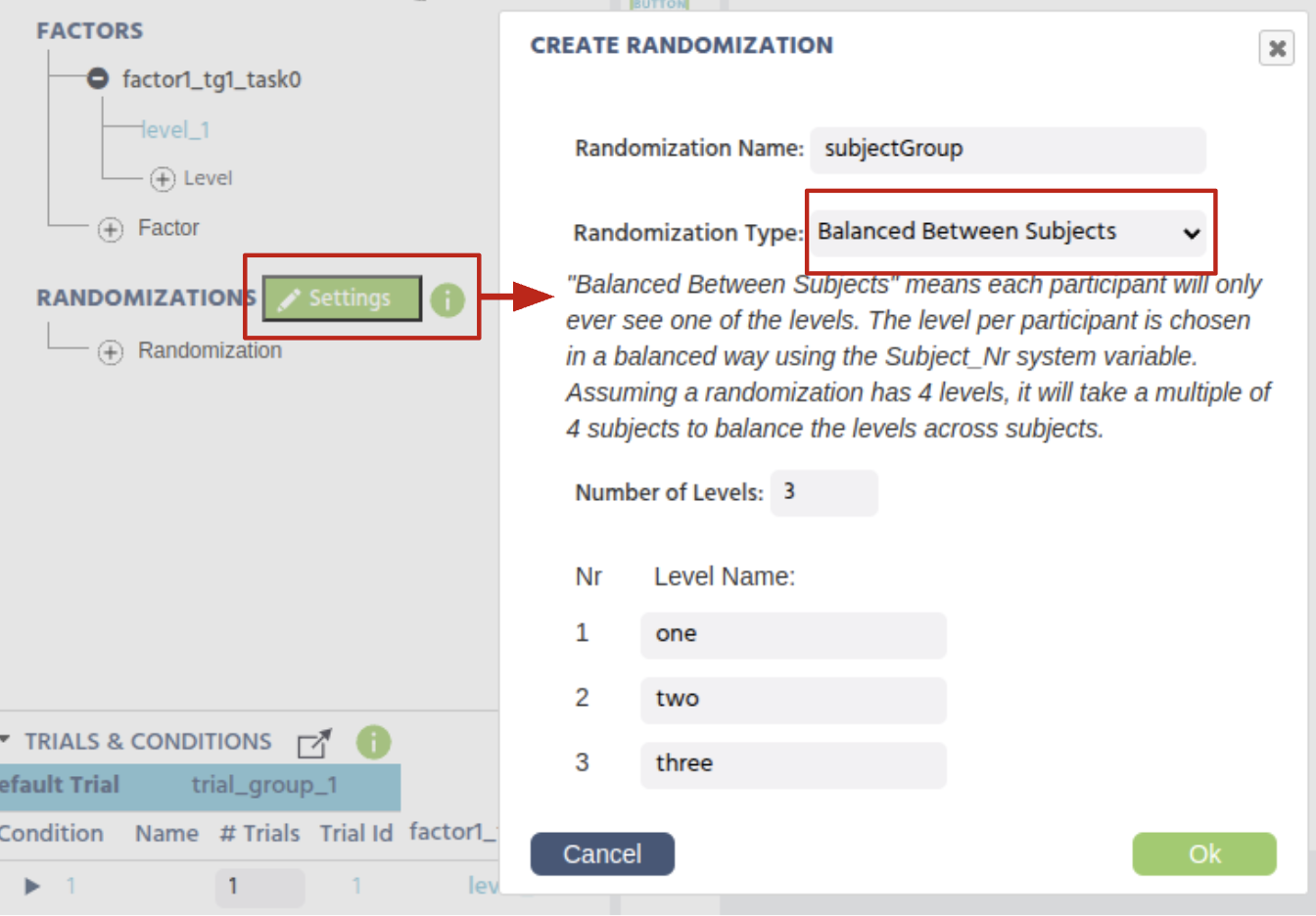

Configuración Sugerida: Crea una variable factorial aleatoria entre sujetos dentro de la tarea. La forma en que funciona es que cada sujeto será asignado a solo un valor de esta variable factorial, que está equilibrada entre sujetos (basada en el Nr del sujeto).

Ahora puedes usar esta variable (factorial), junto con Eventos, para hacer cualquier tipo de cambio dentro de una tarea/marco entre grupos de sujetos.

Escenario de Ejemplo: Un grupo no ve una imagen

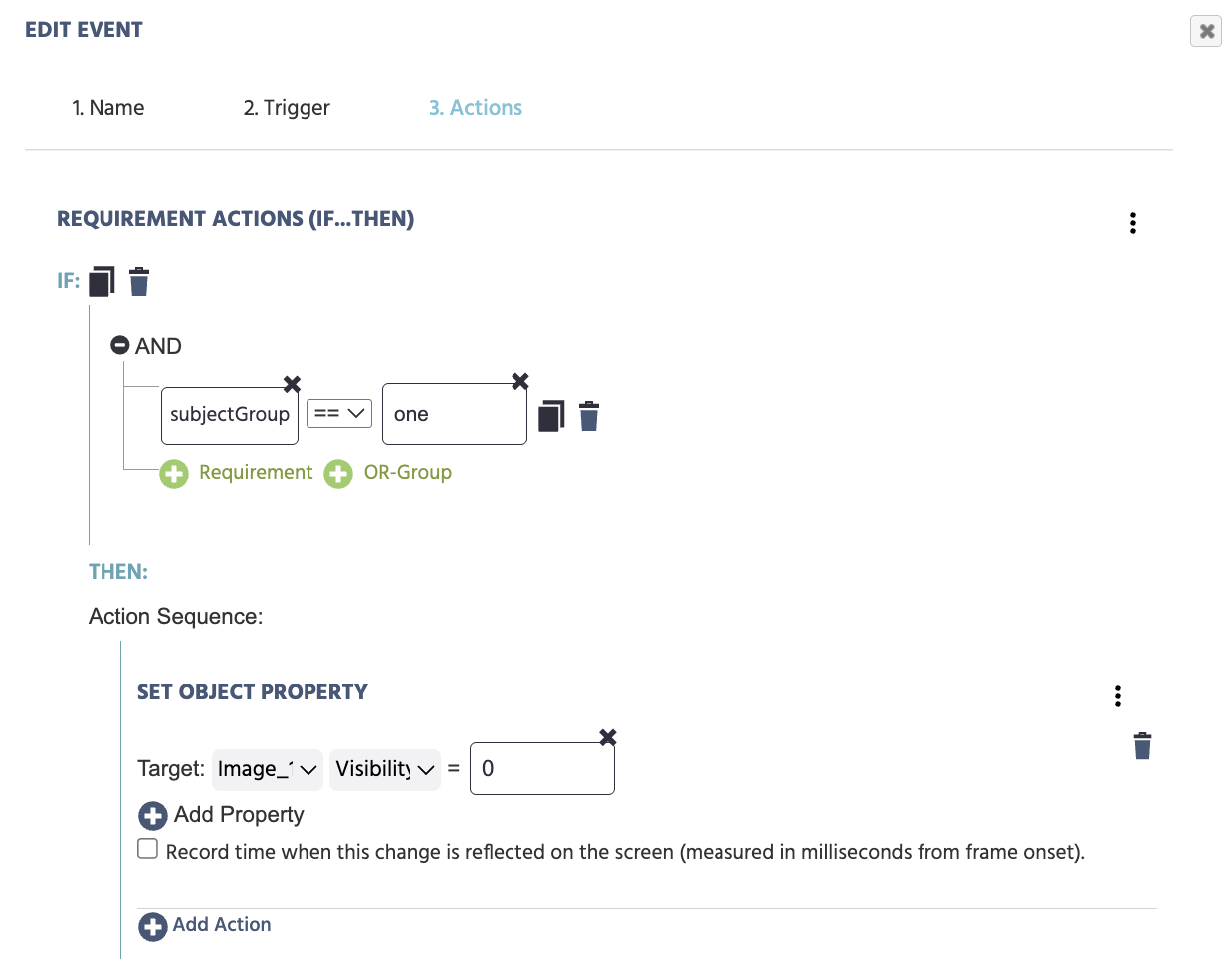

Por ejemplo, puedes crear un evento con disparador de inicio de marco y acción de establecer la propiedad de visibilidad en cero de la imagen:

- Disparador:

Trial and Frame Trigger→On Frame Start - Acción:

Control Actions→Requirement Action (If…Then)- Establecer el primer requisito para llamar a la

Variable→Select Variableluego seleccionar la variable factorial que creamos (subjectGroup) de la lista - En el otro lado de la ecuación, llamar al nivel específico seleccionando:

Constant Value→Stringe indicando el nivel:one

- Establecer el primer requisito para llamar a la

Luego, procede a especificar qué debería ocurrir para este grupo específico, como: Set Object Property: para un objeto (como una imagen) y una propiedad (como visibilidad) para cambiar, como hacer que la propiedad de visibilidad sea cero.

Como resultado, si un sujeto está en el Grupo 1, entonces el objeto de la imagen no se mostrará, mientras que en los otros grupos será visible.

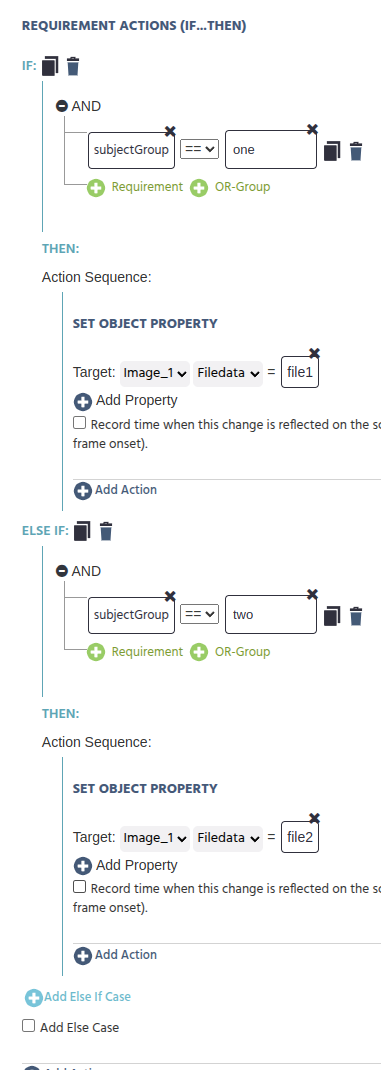

Escenario de Ejemplo: Cada grupo ve una imagen diferente

De manera similar, si deseas hacerlo un poco más poderoso y mostrar una imagen diferente por grupo, entonces puedes hacer algo así:

SI:

subjectGroup== "one"

ENTONCES:

Set Object PropertyAction [image_object] [filedata] = image1 (archivo o configurarlo para que lea de un marco de datos)

SINO SI:

subjectGroup== "two"

ENTONCES:

Set Object PropertyAction [image_object] [filedata] = image2 (archivo o configurarlo para que lea de un marco de datos)

SINO SI:

subjectGroup== "three" ENTONCES:Set Object PropertyAction [image_object] [filedata] = image3 (archivo o configurarlo para que lea de un marco de datos)

Y así sucesivamente... De esta manera, cada grupo de sujetos verá una imagen diferente.

Escenario de Ejemplo: Diferentes Eventos o Acciones por Grupo

También puedes ampliar este caso de uso para que las variables factoriales entre sujetos hagan que los eventos funcionen de manera diferente entre sujetos.

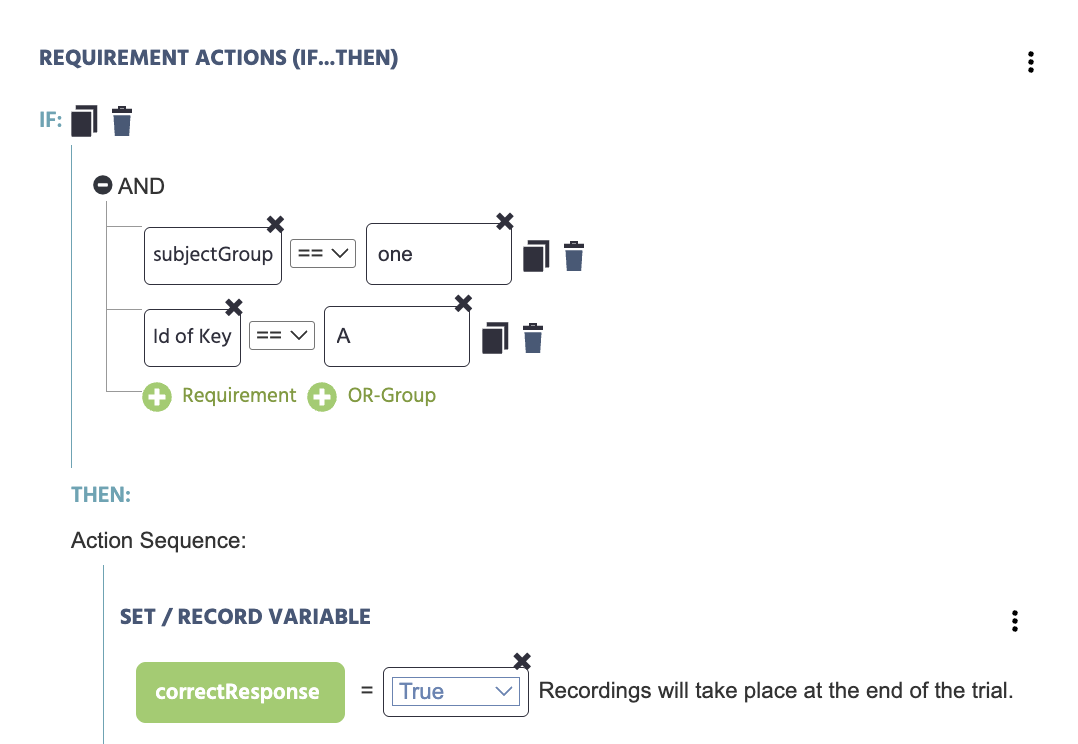

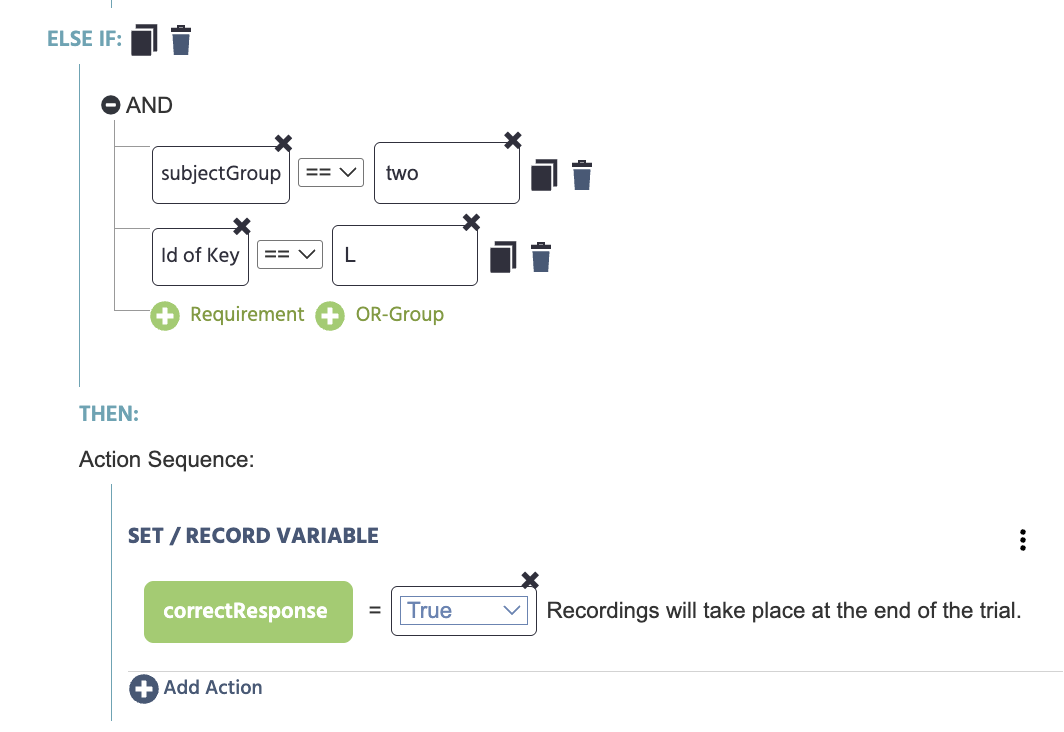

Por ejemplo, si deseas que diferentes grupos de sujetos se balanceen para la pulsación de teclas y la corrección de la asignación de respuestas, puedes hacer un evento con un disparador de pulsación de teclado en la letra A o L y una acción que registre la corrección de la respuesta:

SI:

- subjectGroup == "one"

- Id de tecla == "A"

ENTONCES:

- correctResponse = True

SINO SI:

- subjectGroup == "two"

- Id de tecla == "L"

ENTONCES:

- correctResponse = True

Aquí creamos y establecimos la variable correctResponse para registrar el valor booleano de True.