研究作成に関する質問

これらの質問は、特定のオブジェクトの実装やイベントの使用に関連しています。ここにあなたの質問がない場合は、ガイドの適切なセクションを参照してさらなる情報を見てください。

オブジェクトと変数

実験のためにカウンターを使用したいです。これを実装するにはどうすればよいですか?

通常、カウンターはスカラーの数値変数であり、試行の開始時にリセットされません。フレームに追加し、希望のトリガー(マウスクリック、キー押下、フレームの開始など)を持つイベントを作成します。カウンターを増やすアクションは通常、次のようになります: (counter variable) = (counter variable) + 1。

カウンターを使用して、参加者がビデオまたはオーディオオブジェクトを再生できる回数を設定できます。これを行うには、オーディオ/ビデオの再生が終了するたびに1増加する数値変数(カウンター)を作成します。カウンターが指定された数に達したときにメディアの再生を停止する(または次のフレームにジャンプするなど)というIf-Thenイベントを追加します。

反応時間を記録するための変数をどうやって作成できますか?研究の最後に平均反応時間を報告できますか?

この変数を作成する際、フレームに数値変数を追加します(時間変数ではありません)。特定のトリガーがアクティブになったときに「フレーム開始からの時間」として記録されるべきです。ほとんどの場合、変数は試行の開始時にリセットされるはずです。

参加者へのフィードバックとして平均反応時間を報告するには、上記の手順に従います。次に、totalTimeという新しい数値変数を作成します。反応時間と同じトリガーを持つイベントを設定します。アクションは「変数を設定/記録」され、次の算数の順序になります: totalTime = totalTime + ReactionTime。研究の最終フレームで、Averageという名前の別の数値変数を作成し、次のアクションを設定します: Average = totalTime / (研究内の試行の数)。このようにして、変数「Average」をテキストボックスに追加して、参加者に報告します。これにより、各試行の反応時間および試行全体の平均がデータに表示されます。

変数をテキストとして追加するにはどうすればよいですか?それに何ができますか?

フレームにテキストボックスを追加し、赤い「x」ボタンを使用して変数を挿入します。これは参加者へのフィードバックを提示したり、タスクのトラブルシューティングに使用したりできます(トラブルシューティングの「タスクと試行」を参照してください)。

テキストとして表示される変数の色やサイズは、テキストエディタのソースボタンを使用して変更できます。このボタンをクリックすると、オブジェクトのHTMLソースコードが表示されるウィンドウが開きます。HTMLコードを挿入および編集することで、オブジェクト内のテキストを編集します。

オブジェクトのプロパティを変数として読み取るために記録するにはどうすればよいですか?

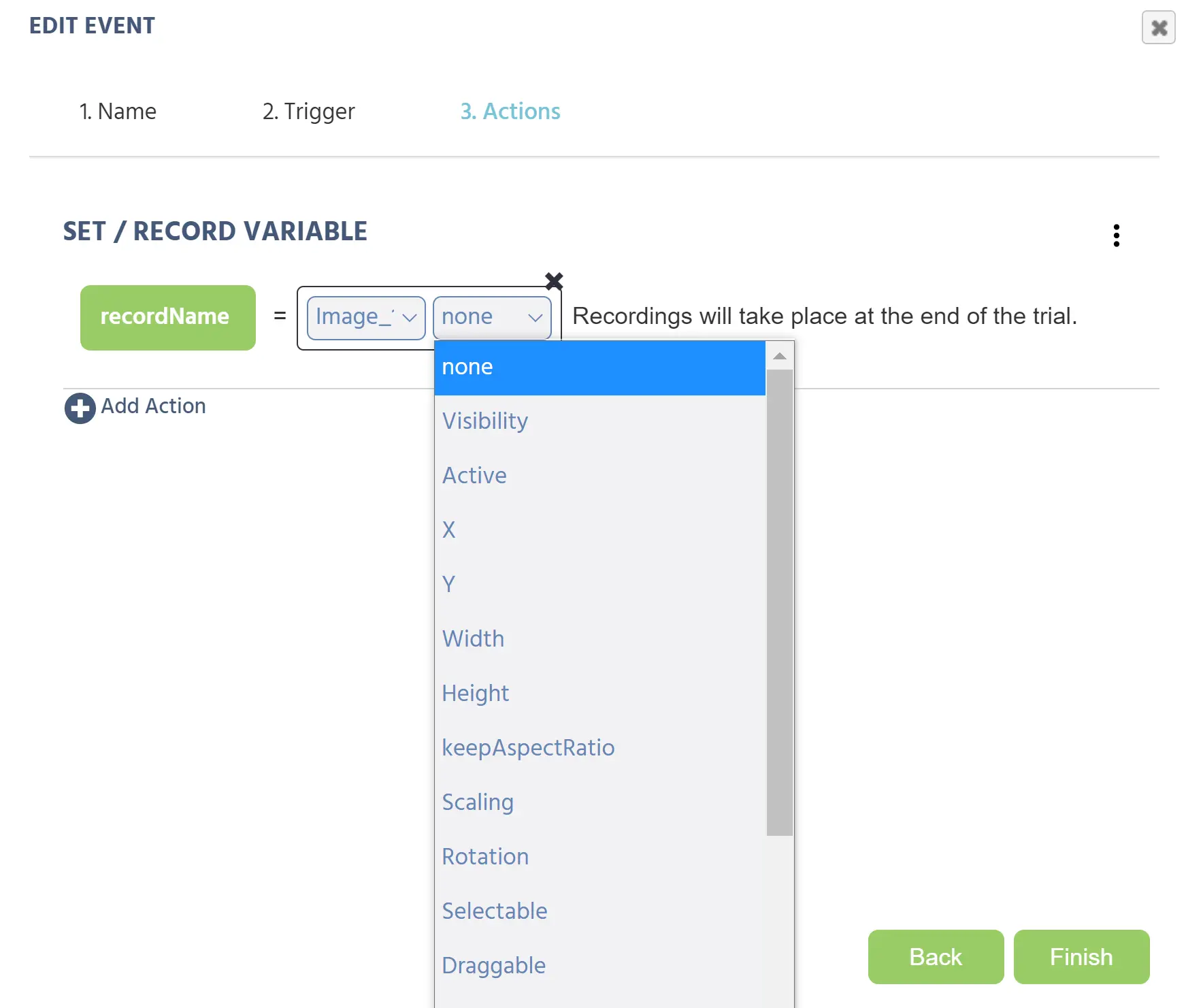

オブジェクトのプロパティを格納するための変数を作成すると、データの解釈がはるかに簡単になります。これを行うには、フレーム内のオブジェクトのプロパティの1つとして変数の値を設定するイベントを追加できます:

この例では、「recordName」という新しい変数が画像オブジェクトのプロパティの1つを記録しようとします。これはSet/Record Variableアクションです。これらのプロパティのほとんどについて、変数の型はテキスト入力の場合「string」であるべきです。ペンアイコンをクリックし、「フレーム/タスク/オブジェクト」メニューを下にスクロールし、次のポップアップから「オブジェクトプロパティ」を選択します。イベントには現在2つの編集可能なボックスが表示されます。最初のボックスは興味のあるオブジェクトで、2番目のボックスは変数内に記録されるプロパティです(左側の緑で表示)。

UNIX時間とは何ですか、そしてなぜ使用されるのですか?

UNIX時間は、1970年1月1日の0時0分UTCから経過した秒数です。この値は、タイムゾーンによって変更されず、非常に大きいが簡単な整数であるため、時間を数えるために使用されます。Labvancedや他のコンピュータシステムは、簡単にタイムスタンプを作成し、データを追跡するためにこれを使用できます。

UNIXタイムスタンプを時計の値に変換するには、次のウェブサイトを参照してください:Epoch Converter

Labvancedアプリケーション内でこの変換を行いたい場合、Java Scriptアクションを使用して行うことができます。このプロセスについて質問がある場合は、ライブチャットでお問い合わせください。

因子の名前はどのように付ければよいですか?

因子の最も重要な側面は、それぞれがユニークな名前を持つ必要があることです。同じラベルを共有する因子は2つ存在してはいけません。また、混乱を避けるために、名前を非常に明確にする方が良いです。因子内のレベル名もユニークであることが非常に重要です。複数の因子を追加し、各因子のレベルに同じ名前がある場合、イベントを実行する際に混乱が生じます。例えば、「position」と「animal」という因子は、どちらも「level 1」、「level 2」といった名前を持つことができません。それぞれ「left」と「right」、「dog」と「cat」といったレベルを持つべきです。

因子と条件に関する注意

1つまたは2つの試行しかない条件やレベルを多数作成することは非常に良くありません。より良いデザインは、各条件に複数の試行を持つ少数の条件を持つことです。もし何百もの小さな条件がある状況にあるなら、研究デザインを再考し、類似の条件を別のタスクに統合することを考慮してください。

イベント

フレームイベントと試行イベントの違いは何ですか?

フレームイベントは、指定されたフレームでのみ発生する従来のイベントです。試行イベントは、研究の各フレームで発生します。それらは、自己ペースのタスクで次のフレームにジャンプするために「スペース」を押すといった冗長なイベントを作成する必要を置き換えることができます。これは研究者がタスクをより迅速に構築するのに役立ちます。

バランスとランダム化

どのように研究を被験者内または間でのバランスを保つように作成できますか?

これにはいくつかの方法があります。1つのオプションは、被験者内のバランスのために複数のブロックを使用し、被験者間のバランスのために複数のグループを使用することです。ただし、タスクのバランスを保つ最良の方法は、因子ツリーと試行システムを使用することだと考えています。これについての詳細は、ガイドの「タスクエディタ」->「試行ランダム化」->「因子ランダム化」を参照してください。バランスをさらに確保するために、研究設定の「スタートアップとメイン設定」で被験者カウンターの設定を調整できます。この情報も研究設定のガイドで利用可能です。

マルチユーザーおよびマルチリンガル研究

研究にビデオ通話/ミーティングを実装することはできますか?

はい、LabvancedはGoogle Meetをサポートしています。それを統合する手順はここにリストされています:

- Labvanced.comでマルチユーザー研究を作成します。

- Meetリンク/URLを持つGoogleカレンダーイベントのシリーズを作成します(各グループのために1つ、時刻/日付は重要ではありません)。

- それらのURLを文字列配列に入れ、同じマルチユーザーグループの人々が同じリンクを見るように読み出します。

- 参加者がリンクをクリックして通話を開始できるように、リンクをURLとしてレンダリングします。

- その「ホストコンピュータ」(任意のコンピュータ)は、すべてのミーティングに参加し、カメラとマイクを無効にしておきます。

- その「ホストコンピュータ」にプラグインをインストールし、Meet通話に参加する人々を自動的に受け入れます。いくつかの代替がありますが、ここでは1つのオプションを示します:プラグイン

- さて、参加者がLabvanced内のMeetリンクをクリックし、「ミーティングに参加をリクエストする」をクリックすると、別のタブで自動的に通話に入ることができます。その結果、研究者の監視なしでミーティングを行うことができます。

研究の最初と最後に静的テキストの言語を変更できますか?

はい、現在Labvancedは中国語、英語、フランス語、ドイツ語、イタリア語、ポーランド語、ポルトガル語、スペイン語の静的テキストをサポートしています。これは研究設定タブのメイン設定で編集できます。

グループライセンス

研究が複数のラボメンバーと共有されている場合、どのようにしてそれが公開されますか?

共有ユーザーは研究を編集できますが、研究の元の所有者のみがそれを公開できます。未編集のバージョンの研究を公開しないために、変更を頻繁に保存してください!

その他

Labvancedを外部デバイス(EEG、フォースプレートなど)に接続するにはどうすればよいですか?

これはウェブソケット経由で行われます。これを行うには、Pythonでのコーディングの強い知識を推奨します。これに関するLabvanced GitHubの指示がこちらにリンクされています:

スクリーン録画やビデオ録画研究から録画されたビデオをどうやって分析できますか?

このデータはFfmpegや類似のプログラムで分析できます。これらのプログラムはデータをフレームごとに分析できます。

参加者のスクリーンサイズをどうやって計算できますか?

研究設定タブで「ブラウザとデバイス」列に移動し、「許可されたスクリーンサイズと解像度」の下で希望の設定を選択します。物理サイズを取得するには、「スクリーンキャリブレーション画面を表示」を選択します。これにより、研究の開始時に参加者がカードの画像をドラッグしてサイズを変更するように求める画面が表示されます。そのカード画像のサイズをスクリーンに持っている実際の標準カード(メトロカードやIDなど)のサイズと一致させることで、標準カードサイズに基づいて参加者のスクリーンのサイズを推測できます。