タスクにおけるアイ・トラッキング

説明

タスクエディターの左上側パネルで、物理信号メニューの横にある「編集」をクリックすると、アイ・トラッキングの設定にアクセスできます。

![]()

タスクでアイ・トラッキングを有効にするには、「このタスクでアイ・トラッキングを有効にする」チェックボックスにチェックを入れてください。研究が始まる前に、参加者は使用したいウェブカメラを選択するよう促され、接続された外部ウェブカメラと内蔵システムを選択できます。アイ・トラッキングが有効な最初のタスクが始まる前に、主要なアイ・トラッキングのキャリブレーションが自動的に行われます。さらに、このタスクに対してアイ・トラッキングを有効にすると、各試行の前に頭の向きがチェックされます。

複雑な形状をマスクやAOIとして使用するためのSVGとポリゴン

デザインプロセスの一環として、マスクやAOIとして機能する複雑な形状を作成するために、SVGとポリゴンの形状オブジェクトを利用することを検討するかもしれません。SVGはLabvancedにアップロードでき、ポリゴンはアプリエディター内で直接描くことができます。これらの2つのオプションを使用すると、複雑な形状/領域を作成し、それらをLabvancedでのアイ・トラッキング実験の基盤として使用できます。

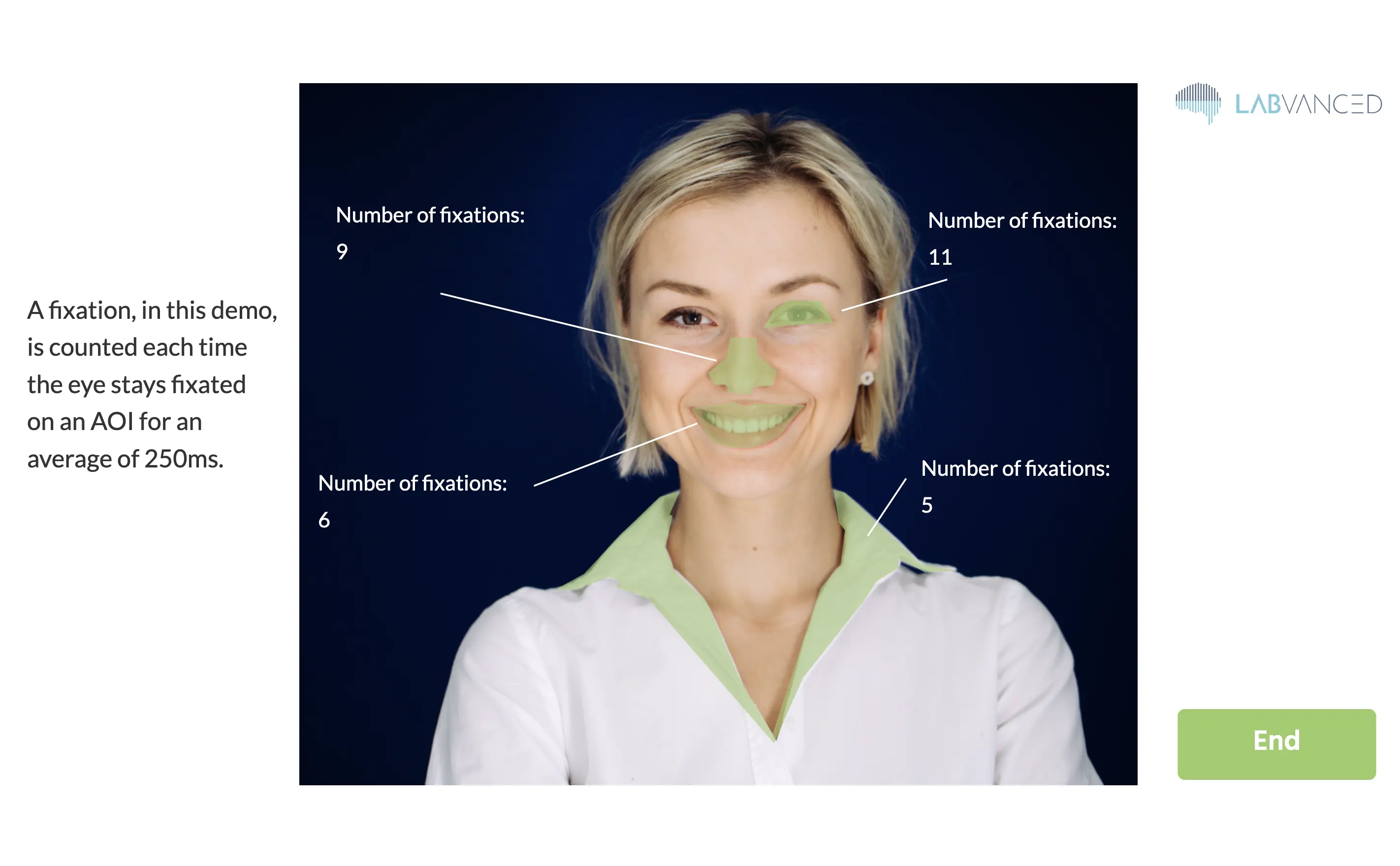

たとえば、ポリゴン形状を「トリガー」として実装することで、参加者がそれに注視するたびに、その注視をカウントする変数が1増加します!このデモの設定方法は、ここで確認できます:https://www.labvanced.com/page/library/61117 「検査」をクリックしてタスクの構造を確認したり、「参加」をクリックして参加したりできます。下の画像はデモの結果を示しています。

上記のデモでは、最も速いキャリブレーション設定が使用されているため(約1分)、実験を迅速に進めることができます。

試行間注視

タスクのアイ・トラッキング設定で、試行間に表示する注視の数を定義できます。これらの試行間注視には以下の目的があります:

- 各試行の前にアイ・トラッキングの精度を計算するために使用されます。

- 「試行ごとのドリフト補正」を有効にすると、ドリフトは表示された注視点と予測された視線位置の中央値の差として計算されます。次の試行中のすべての視線予測は、この推定されたオフセットによって自動的に補正されます。

アイ・トラッキングの記録

以下は、視線位置の[X,Y]座標のタイムシリーズを記録するための推奨方法です。

- トリガー「アイ・トラッキング」を使用してイベントを作成します。これは、新しい視線位置が予測されるたびに自動的に実行されます。

- 新しい視線位置を記録するには、「変数の設定/記録」アクションを追加します。このアクションでは、左側で視線位置を保存するための新しい記録変数を作成します。

- x座標とy座標のペアを保存するには、フォーマット「配列」を選択するのが最適です。

- 時間の経過とともにすべての視線位置を記録したい場合は、記録タイプを「すべての変更/タイムシリーズ」に切り替えます。

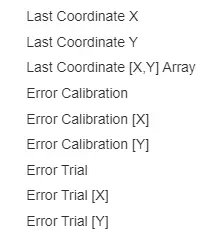

- アクションの右側の値選択メニューで、「アイ・トラッキング」サブメニューから「最後の座標[X,Y]配列」を選択します(図を参照)。

結果として記録される視線座標は、フレーム上の要素を配置するために使用された設計単位であり、視線座標を刺激位置に簡単に関連付けることができます。

データ出力

視線データごとに記録される4つの基本値があります:

- X: フレーム単位でのx(水平)位置

- Y: フレーム単位でのy(垂直)位置

- T: 視線の正確/修正されたタイムスタンプ

- C: 視線検出の信頼度(0は目の閉じまたは顔/目が見えないことを示し、1は100%の信頼性を示します)

アイ・トラッキングの精度

予測された視線座標の精度は、異なる被験者やそれぞれの環境(照明やカメラ)によって異なるため、予測誤差の推定値を提供します。これらの推定誤差は、「変数の設定/記録」アクションの右側の値選択メニューでアクセスできます。誤差値は、予測された視線座標と表示されたターゲット注視位置との間の平均ユークリッド距離です。これらのユークリッド距離に加えて、水平([X])または垂直([Y])誤差成分のみの誤差推定値もあります。誤差値には2つのタイプがあります:

- 「エラーキャリブレーション...」値は、初期キャリブレーション期間中にキャプチャされた注視の検証セットを使用して計算されます。

- 「エラー試行...」値は、試行間注視を使用して計算されます。