Eyetracking in einer Aufgabe

Beschreibung

Klicken Sie im linken oberen Seitenbereich des Aufgabeneditors neben dem Menü Physikalische Signale auf Bearbeiten, um es zu öffnen und auf die Eyetracking-Einstellungen der Aufgabe zuzugreifen.

![]()

Um Eyetracking in der Aufgabe zu aktivieren, aktivieren Sie bitte das Kontrollkästchen "Eyetracking in dieser Aufgabe aktivieren". Bevor die Studie beginnt, werden die Teilnehmer aufgefordert, auszuwählen, welche Webcam sie verwenden möchten, wodurch die Auswahl einer angeschlossenen externen Webcam oder einer integrierten Systemkamera möglich ist. Die Hauptkalibrierung für Eyetracking erfolgt automatisch vor Beginn der ersten Aufgabe mit aktiviertem Eyetracking. Darüber hinaus wird, wenn Sie Eyetracking für diese Aufgabe aktivieren, die Kopfhaltung vor jedem Versuch überprüft.

SVGs und Polygone zur Verwendung komplexer Formen als Masken und AOIs

Im Rahmen des Designprozesses möchten Sie möglicherweise in Betracht ziehen, SVG- und Polygon-Formobjekte zu nutzen, um komplexe Formen zu erstellen, die als Masken oder AOIs fungieren können. SVGs können in Labvanced hochgeladen werden, während Polygone direkt im App-Editor gezeichnet werden können. Diese beiden Optionen ermöglichen es Ihnen, komplexe Formen / Bereiche zu erstellen und diese dann als Grundlage für Ihr Eyetracking-Experiment in Labvanced zu verwenden.

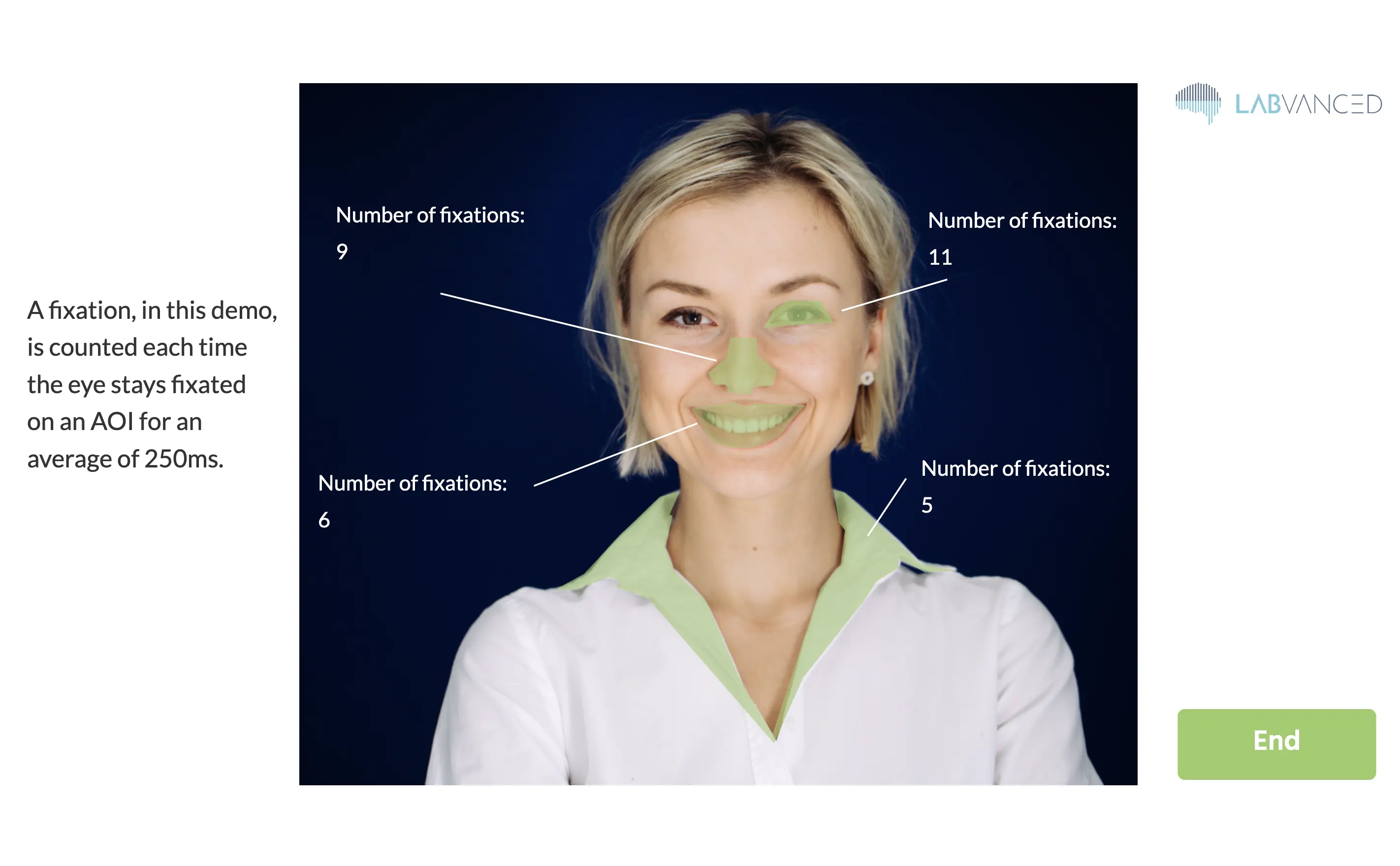

Zum Beispiel können Sie eine Polygonform als "Auslöser" implementieren, sodass jedes Mal, wenn der Teilnehmer darauf fixiert, die Variable, die diese Fixationen zählt, um eins erhöht wird! Sie können sehen, wie dies in dieser Demo eingerichtet ist: https://www.labvanced.com/page/library/61117, indem Sie auf "Untersuchen" klicken und die Aufgabe öffnen, um die Struktur zu sehen, oder auf "Teilnehmen", um teilzunehmen. Die folgende Abbildung zeigt das Ergebnis der Demo.

Bitte beachten Sie, dass in der obigen Demo die schnellsten Kalibrierungseinstellungen verwendet werden (ca. 1 Minute lang), damit Sie schnell durch das Experiment fortfahren können.

Zwischenversuchsfixationen

In den Eyetracking-Einstellungen der Aufgabe können Sie die Anzahl der Fixationen festlegen, die zwischen den Versuchen angezeigt werden sollen. Diese Zwischenversuchsfixationen haben folgenden Zweck:

- Sie dienen dazu, die Genauigkeit des Eyetrackings vor jedem Versuch zu berechnen.

- Wenn Sie "driftkorrektur pro Versuch" aktivieren, wird der Drift als der Medianunterschied zwischen den angezeigten Fixationspunkten und den vorhergesagten Blickpositionen berechnet. Jede Blickvorhersage während des folgenden Versuchs wird dann automatisch um diesen geschätzten Offset korrigiert.

Aufzeichnung von Eyetracking

Folgendes ist der empfohlene Weg, um eine Zeitreihe von [X,Y] Koordinaten der Blickpositionen aufzuzeichnen.

- Erstellen Sie ein Ereignis mit dem Auslöser "Eyetracking", der automatisch jedes Mal ausgeführt wird, wenn eine neue Blickposition vorhergesagt wird.

- Um die neue Blickposition aufzuzeichnen, fügen Sie die Aktion "Variable setzen / aufzeichnen" hinzu. In dieser Aktion erstellen Sie auf der linken Seite eine neue aufgezeichnete Variable, um die Blickpositionen zu speichern.

- Um ein Paar von x- und y-Koordinaten zu speichern, ist es am besten, das Format "Array" zu wählen.

- Wenn Sie alle Blickpositionen über die Zeit aufzeichnen möchten, wechseln Sie dann den Aufzeichnungs-Typ auf "Alle Änderungen / Zeitreihe".

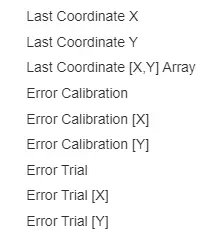

- Wählen Sie auf der rechten Seite der Aktion im Menü zur Wertauswahl "Letzte Koordinate [X, Y] Array" aus dem Untermenü "Eyetracking" (siehe Abbildung).

Die resultierenden aufgezeichneten Blickkoordinaten befinden sich in den Design-Einheiten, die verwendet wurden, um Elemente auf Ihren Frames zu positionieren, sodass Sie Koordinaten leicht mit Ihren Stimuluspositionen verbinden können.

Datenausgabe

Es werden 4 grundlegende Werte pro Blickdaten aufgezeichnet:

- X: x (horizontale) Position in Frame-Einheiten

- Y: y (vertikale) Position in Frame-Einheiten

- T: präziser/korrigierter Zeitstempel für den Blick

- C: Vertrauen in die Blickerkennung (0 bedeutet Augen schließen oder kein Gesicht/Auge sichtbar, 1 bedeutet 100 % Vertrauen)

Genauigkeit des Eyetrackings

Bitte beachten Sie, dass die Genauigkeit der vorhergesagten Blickkoordinaten zwischen verschiedenen Probanden und deren entsprechender Umgebung (d.h. Lichtverhältnisse und Kamera) variiert. Daher bieten wir Schätzungen der Vorhersagefehler an. Diese geschätzten Fehler können im Menü zur Wertauswahl (auf der rechten Seite einer Aktion "Variable setzen / aufzeichnen") abgerufen werden. Die Fehlerwerte sind der durchschnittliche euklidische Abstand zwischen vorhergesagten Blickkoordinaten und den angezeigten Ziel-Fixationspositionen. Neben diesen euklidischen Abständen gibt es auch Fehlerabschätzungen nur für die horizontalen ([X]) oder vertikalen ([Y]) Fehlerkomponenten. Es gibt zwei Arten von Fehlerwerten:

- "Fehler Kalibrierung ..." Werte werden mit einem Validierungsdatensatz von während der anfänglichen Kalibrierungsphase erfassten Fixationen berechnet.

- "Fehler Versuch ..." Werte werden mit den inter-trial Fixationen berechnet.