Zwischen-Gruppen-Balancing und Variablen-Setup

Wie können Sie einen Teil der Teilnehmer so einrichten, dass sie Version X sehen, während die anderen Version Y sehen?

Für die zwischen-subjektliche Randomisierung gibt es einige Möglichkeiten, dies in Labvanced umzusetzen.

Es gibt zwei allgemeine Ansätze / Szenarien, und der beste hängt, wie immer, von den Details und Ihrem besonderen Studiendesign ab.

SZENARIO 1: Unabhängige Aufgaben und Gruppen

Grad des Unterschieds zwischen den Gruppen: Es gibt einen relativ großen Unterschied zwischen den Teilnehmergruppen, d.h. die Unterschiede sind erheblich und umfassen mehrere Rahmen, Objekte oder Ereignisse.

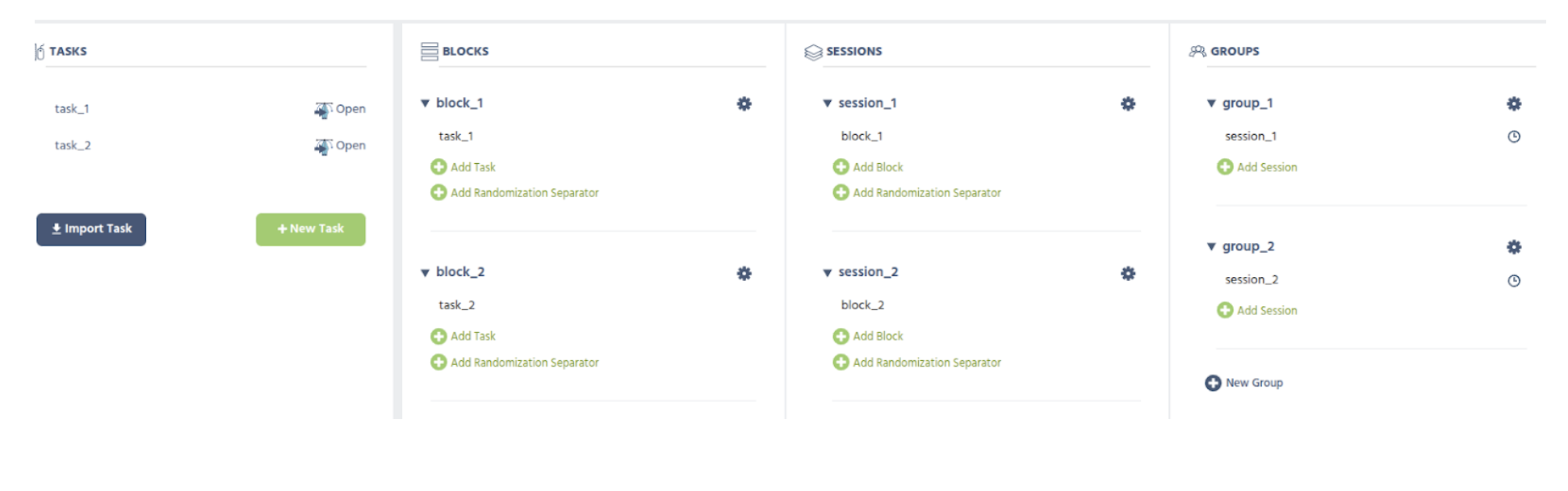

Vorgeschlagene Einrichtung: Erstellen Sie zwei (oder so viele wie Sie benötigen) Teilnehmergruppen und weisen Sie die unterschiedlichen Aufgaben den verschiedenen Gruppen zu. Im Bild unten wird ein vereinfachtes Studiendesign dargestellt, das diese Idee zeigt – wo die Hälfte der Teilnehmer (in Gruppe 1)

task_1machen würde, die andere Hälfte (in Gruppe 2)task_2machen würde.Abwägung: Bedenken Sie, dass der Nachteil dieses Ansatzes besteht, darin, dass Sie tatsächlich separate und unabhängige Aufgaben haben, was erfordert, dass Sie alles zweimal erledigen, d.h. eine neue Änderung, die in beiden Gruppen erforderlich ist, muss in beiden Aufgaben separat implementiert werden. Daher ist dies nur eine gute Option, wenn der Unterschied recht groß ist und es besser ist, zwei oder mehr vollkommen separate Implementierungen zu haben.

SZENARIO 2: Faktorvariablen

Grad des Unterschieds: Der Unterschied zwischen den Teilnehmergruppen ist eher klein, d.h. einige „Details“ (z.B. ein Objekt ist sichtbar oder nicht / welches Bild gezeigt wird) innerhalb einer ansonsten ähnlichen Aufgabenstruktur.

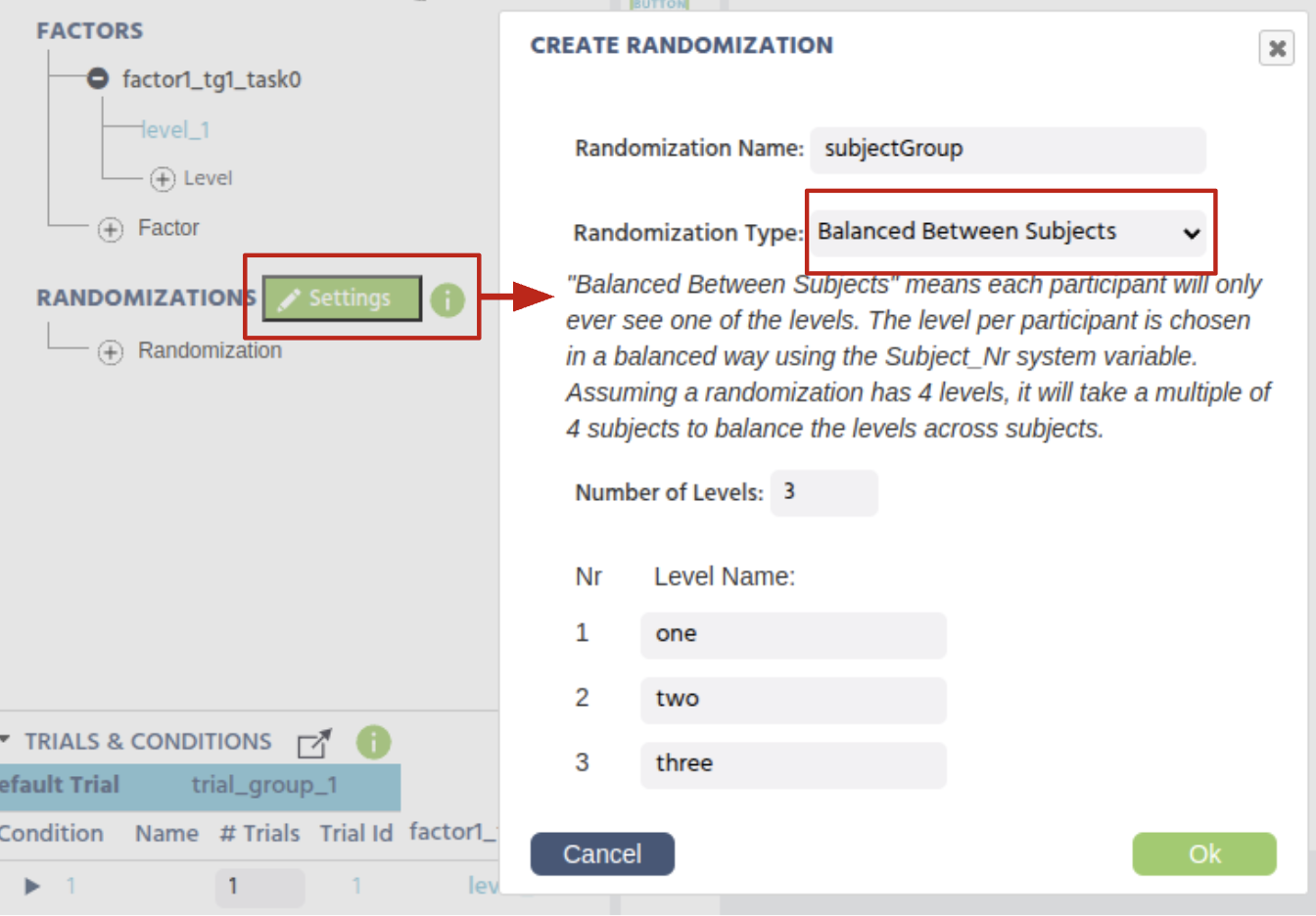

Vorgeschlagene Einrichtung: Erstellen Sie eine Zufallsfaktorvariable innerhalb der Aufgabe. So funktioniert es, dass jeder Teilnehmer nur einem Wert dieser Faktorvariable zugewiesen wird, die über die Teilnehmer hinweg (basierend auf der Teilnehmernummer) balanciert ist.

Jetzt können Sie diese (Faktor-)Variable zusammen mit Ereignissen verwenden, um jegliche Änderungen innerhalb einer Aufgabe/ eines Rahmens zwischen den Gruppen der Teilnehmer vorzunehmen.

Beispielszenario: Eine Gruppe sieht kein Bild

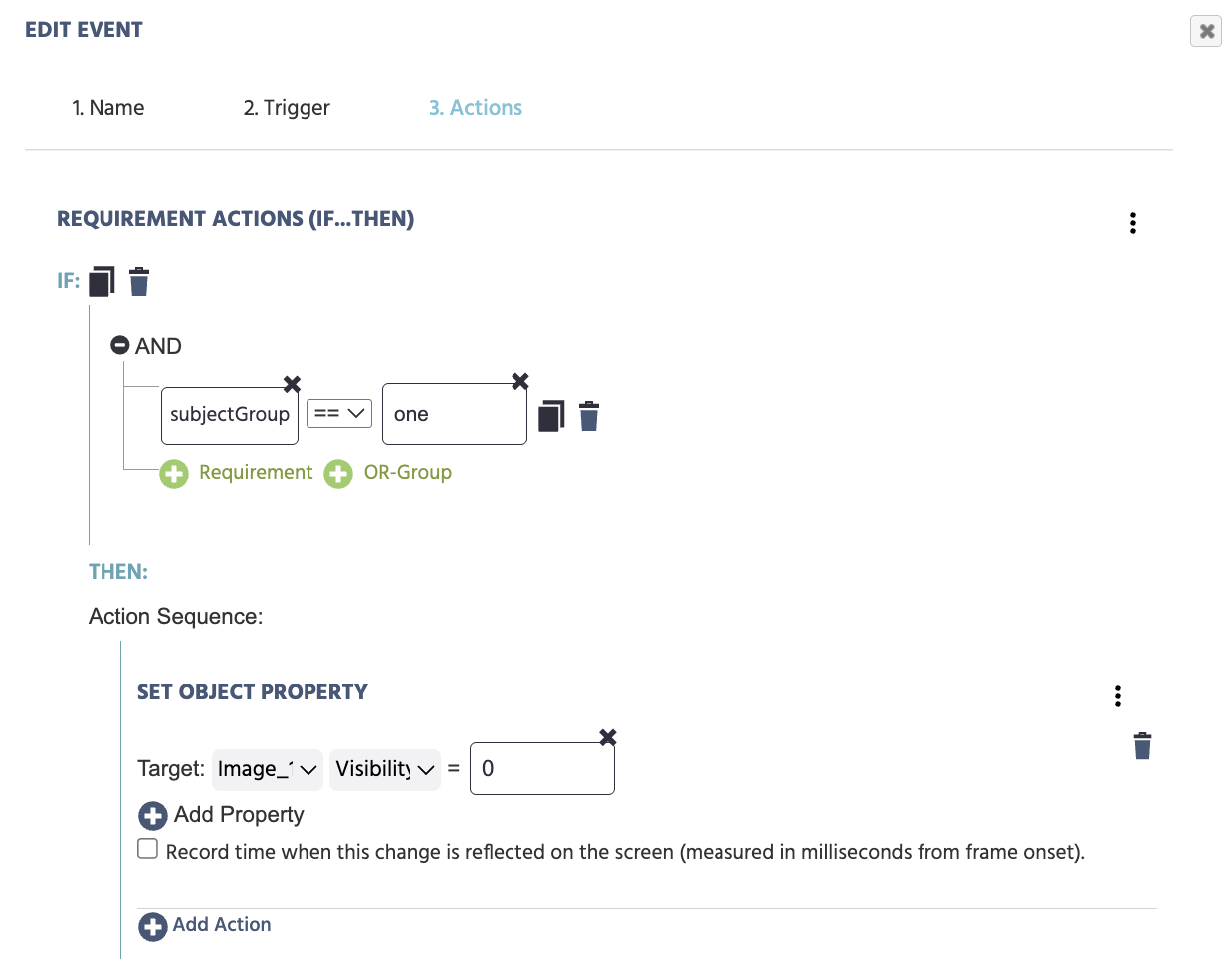

Zum Beispiel können Sie ein Ereignis mit dem Auslöser "Rahmenstart" und der Aktion erstellen, die Sichtbarkeitseigenschaft des Bildes auf null zu setzen:

- Auslöser:

Trial und Frame Trigger→Bei Rahmenstart - Aktion:

Steuerungsaktionen→Anforderungsaktion (Wenn…Dann)- Setzen Sie die erste Anforderung, um die

Variableaufzurufen →Variable auswählen, und wählen Sie dann die von uns erstellte Faktorvariable (subjectGroup) aus der Liste aus. - Auf der anderen Seite der Gleichung rufen Sie das spezifische Niveau auf, indem Sie auswählen:

Konstanter Wert→Stringund das Niveau angeben:one

- Setzen Sie die erste Anforderung, um die

Fahren Sie dann fort, um festzulegen, was für diese spezifische Gruppe geschehen soll, z.B.: Objekt-Eigenschaft festlegen: für ein Objekt (wie ein Bild) und eine Eigenschaft (wie Sichtbarkeit) zu ändern, z.B. die Sichtbarkeitseigenschaft auf null zu setzen.

Das Ergebnis ist, dass, wenn ein Teilnehmer in Gruppe 1 ist, das Bildobjekt nicht angezeigt wird, während es in den anderen Gruppen sichtbar sein wird.

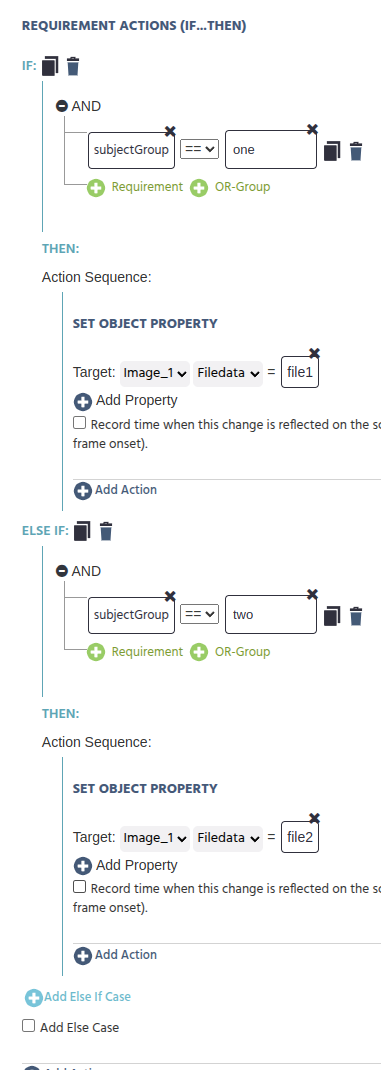

Beispielszenario: Jede Gruppe sieht ein anderes Bild

Ähnlich können Sie, wenn Sie es etwas leistungsfähiger gestalten und jeder Gruppe ein anderes Bild zeigen möchten, Folgendes tun:

WENN:

subjectGroup== "one"

DANN:

Objekt-Eigenschaft festlegenAktion [image_object] [filedata] = image1 (Datei oder so einstellen, dass sie aus einem Datengerüst gelesen wird)

SONST WENN:

subjectGroup== "two"

DANN:

Objekt-Eigenschaft festlegenAktion [image_object] [filedata] = image2 (Datei oder so einstellen, dass sie aus einem Datengerüst gelesen wird)

SONST WENN:

subjectGroup== "three" DANN:Objekt-Eigenschaft festlegenAktion [image_object] [filedata] = image3 (Datei oder so einstellen, dass sie aus einem Datengerüst gelesen wird)

Und so weiter... Auf diese Weise wird jede Teilnehmergruppe ein anderes Bild sehen.

Beispielszenario: Verschiedene Ereignisse oder Aktionen pro Gruppe

Sie können diesen Anwendungsfall auch erweitern, sodass zwischen-subjektliche Faktorvariablen Ereignisse erzeugen, die zwischen den Teilnehmern unterschiedlich funktionieren.

Zum Beispiel, wenn Sie möchten, dass verschiedene Teilnehmergruppen für die Tastenanschläge und die Richtigkeit der Antwortzuweisung balancieren, können Sie ein Ereignis mit dem Auslöser Tastendruck auf den Buchstaben A oder L und einer Aktion, die die Richtigkeit der Antwort aufzeichnet, erstellen:

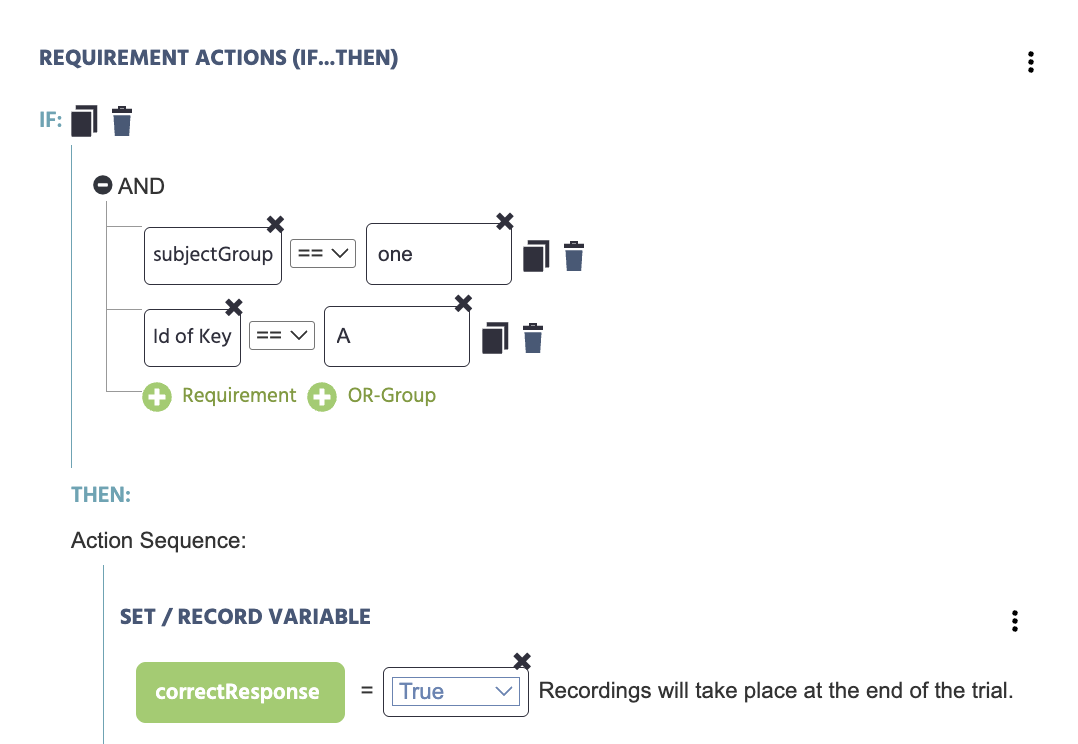

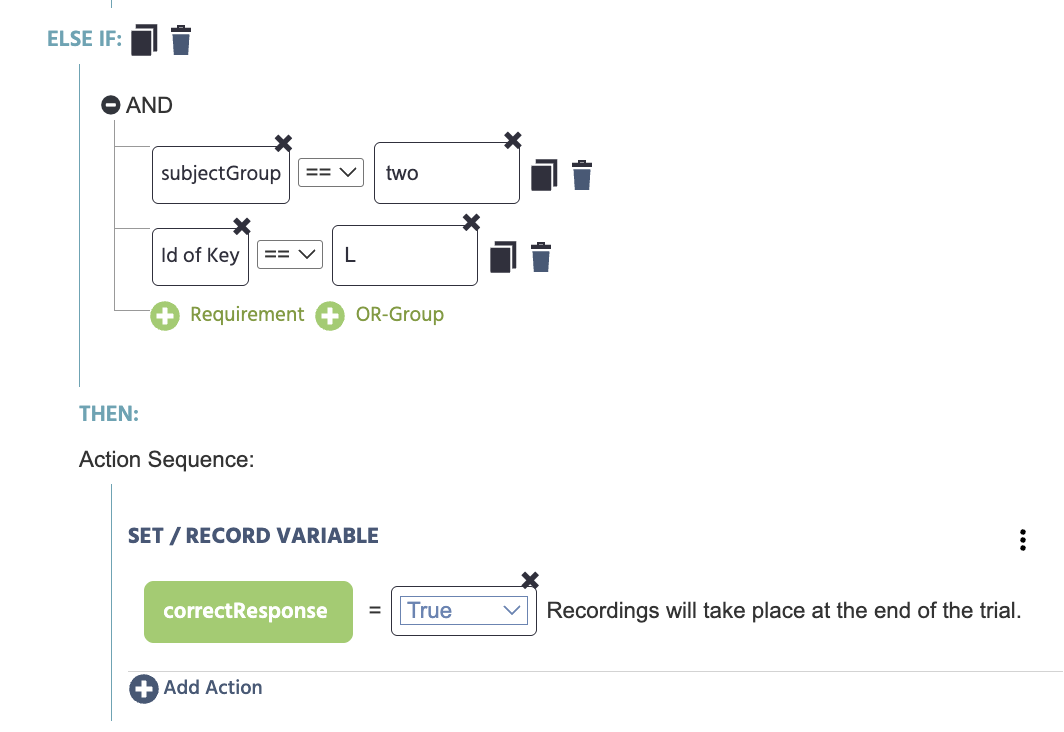

WENN:

- subjectGroup == "one"

- Id der Taste == "A"

DANN:

- correctResponse = True

SONST WENN:

- subjectGroup == "two"

- Id der Taste == "L"

DANN:

- correctResponse = True

Hier haben wir die Variable correctResponse erstellt und gesetzt, um den booleschen Wert von True zu erfassen.