OpenAI Trigger

Übersicht

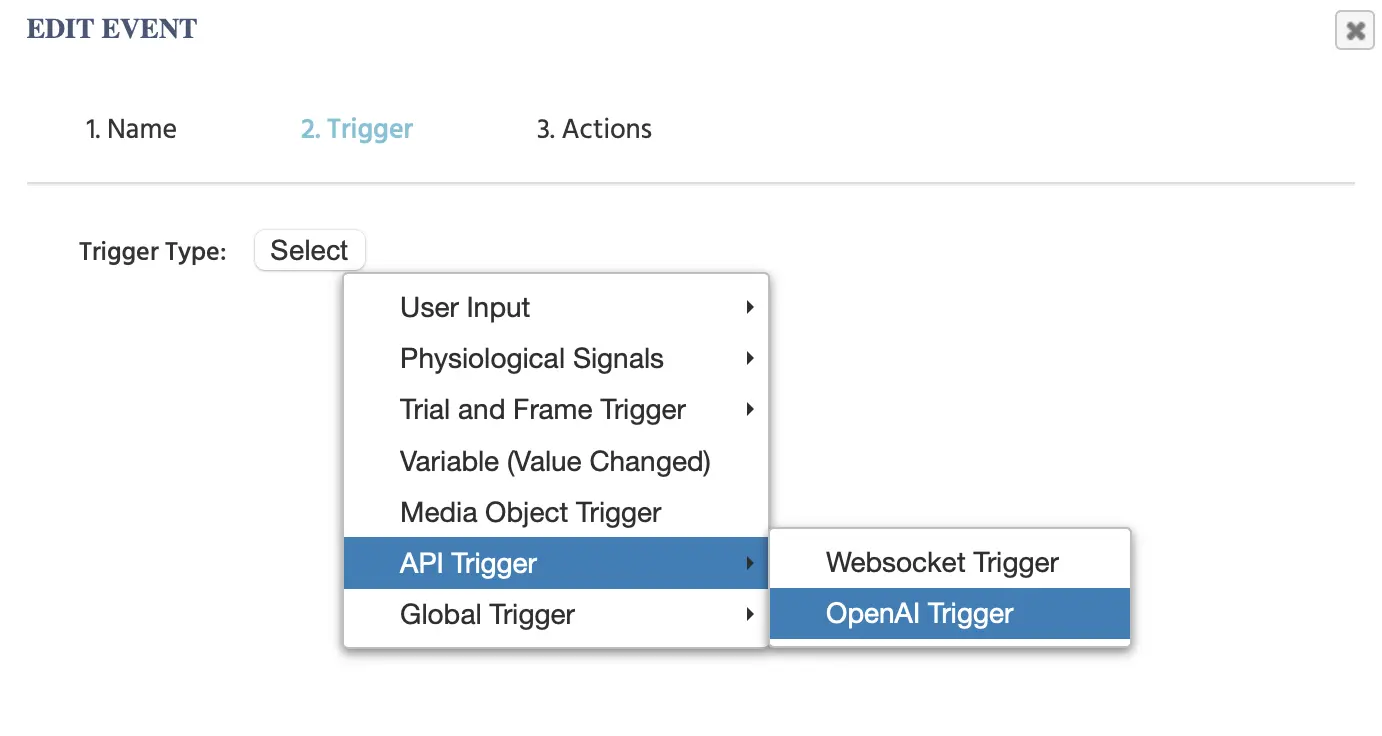

Der OpenAI Trigger (aufgeführt unter API Triggers im Hauptmenü) kann verwendet werden, um eine Aktion basierend auf eingehenden Informationen von OpenAI zu initiieren. Mit diesem Trigger können Sie angeben, welche Art von eingehenden Informationen als Auslöser verwendet werden soll, wie z.B. textbasierte, bild- oder audio-basierte, durch Auswahl eines der verschiedenen aufgeführten Model Types.

HINWEIS: Damit diese Option verfügbar ist, müssen Sie zunächst Ihren API-Schlüssel im Tab Settings auflisten.

Wenn Sie diese Option auswählen, werden die folgenden Parameter angezeigt:

Verfügbare Modeltypen

Mit dem Dropdown-Menü Model Type stehen die folgenden Optionen zur Verfügung:

| Model Type | Beschreibung |

|---|---|

ChatGPT | Eingehende textbasierte Antworten von OpenAI |

Image Generation | Eingehende bildbasierte Antworten |

Generate Audio | Eingehende audio-basierte Antworten |

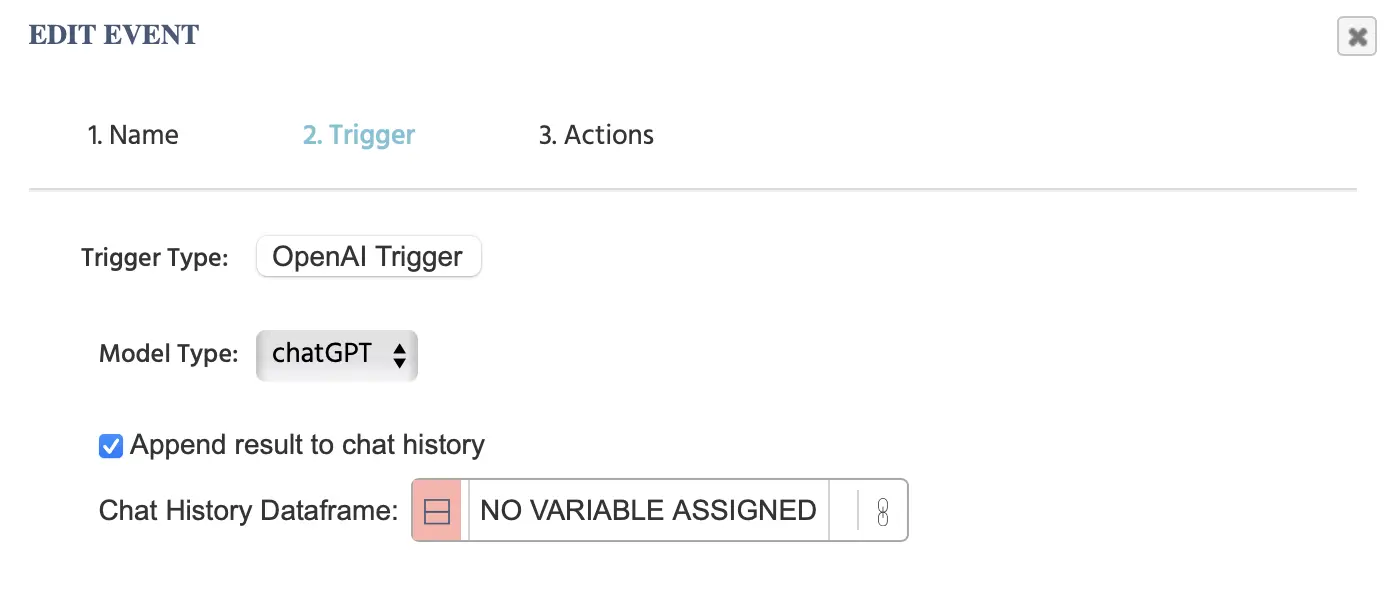

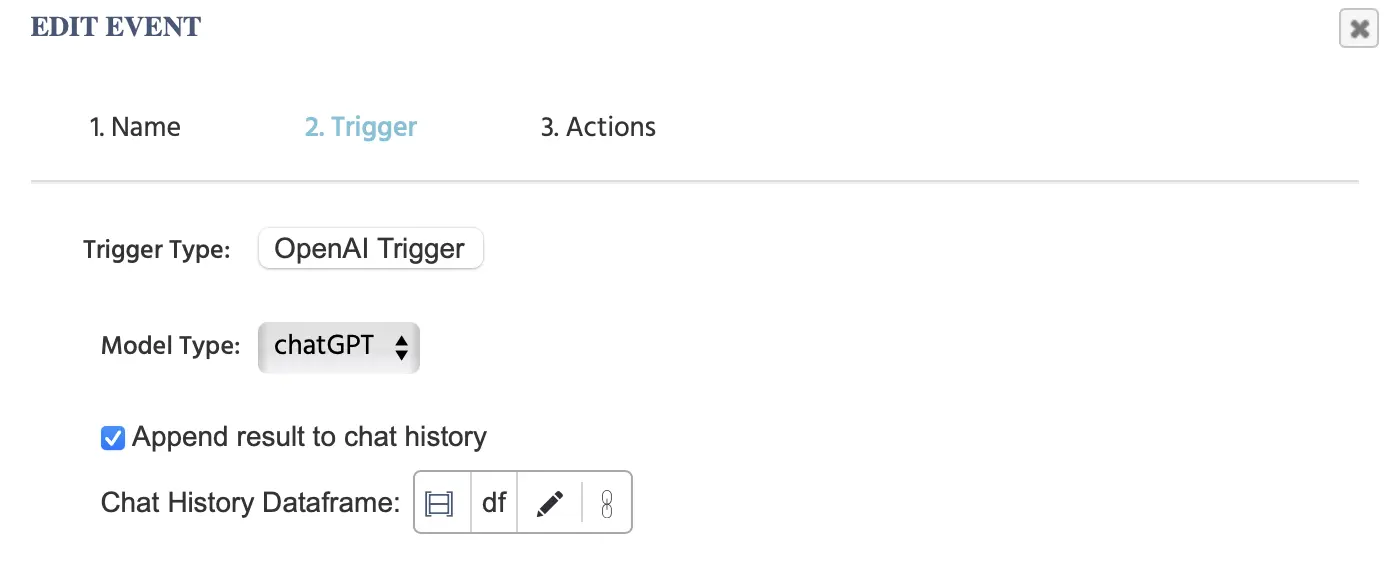

ChatGPT Model Type

Im folgenden Beispiel wird der zugewiesene Datenrahmen als „df“ bezeichnet und das Ergebnis vom „OpenAI Trigger“ wird an diesen Datenrahmen angehängt. Dieser Datenrahmen muss zwei Spalten haben. Die erste Spalte gibt die „Rolle“ an und die zweite Spalte die „Chat-Nachricht“. Die Werte der Aktion werden automatisch an den hier verlinkten Datenrahmen angehängt.

HINWEIS 1: Wenn Sie auch die „Send to OpenAI“ Aktion, verwenden, müssen Sie denselben Datenrahmen dort verwenden, wie Sie hier angegeben haben.

HINWEIS 2: Verweisen Sie auch auf dieses Walkthrough, in dem wir eine Studie Schritt für Schritt aufbauen und ChatGPT für eine textbasierte Studie mit einem Chat integrieren und diese Auslöseroptionen nutzen.

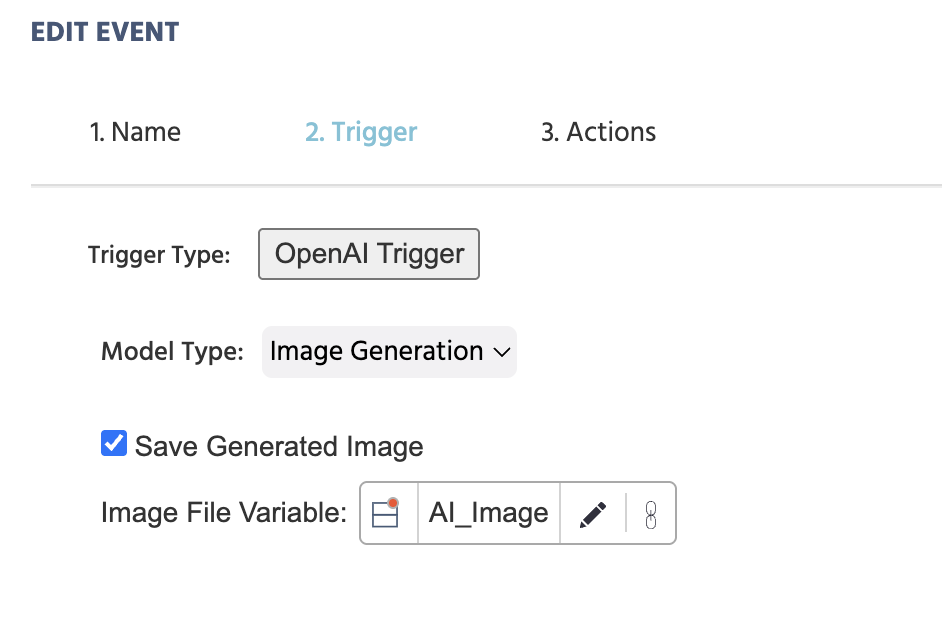

Bildgenerierung - Model Type

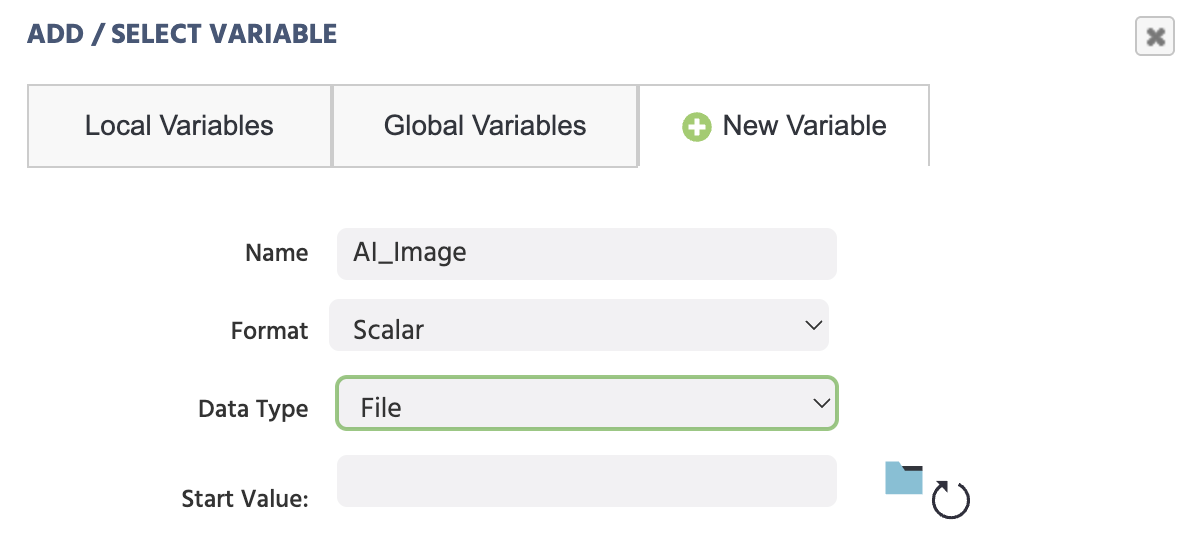

Mit dieser Option können Sie ein generiertes Bild angeben, das gespeichert werden soll, und auch angeben, in welcher Variablen es gespeichert werden soll.

HINWEIS: Beim Zuordnen und Erstellen der jeweiligen Variablen hier, denken Sie daran, den Variablentyp als File anzugeben, damit die Bilddatei dort gespeichert werden kann.

Nützliche Demo: Schauen Sie sich diese Demo an, die die Bildgenerierung über den OpenAI Trigger und die Aktion nutzt. Der Teilnehmer wird gebeten, ein Eingabeaufforderung einzugeben, und diese Eingabeaufforderung wird dann zur Generierung eines Bildes verwendet.

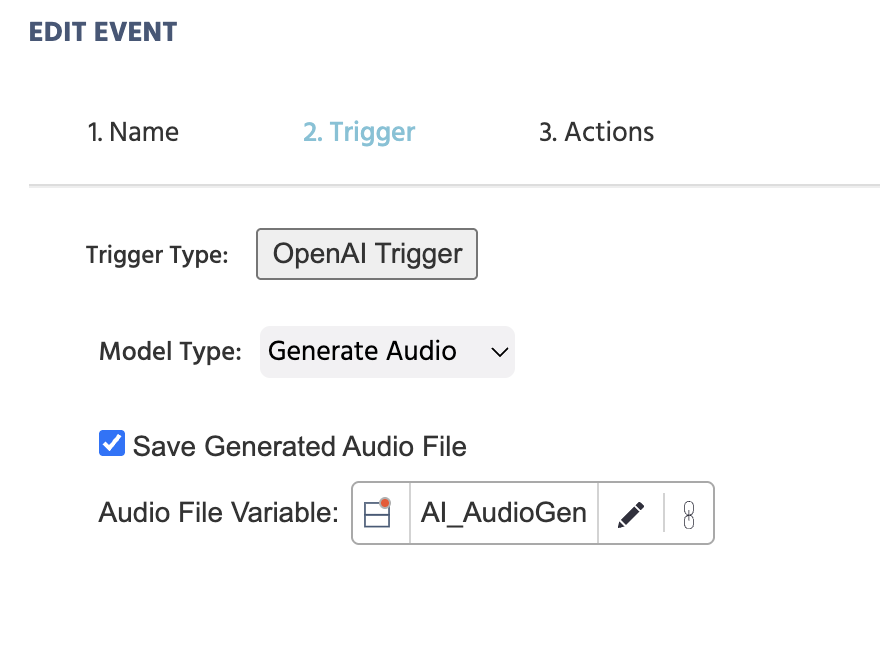

Audio Generierung - Model Type

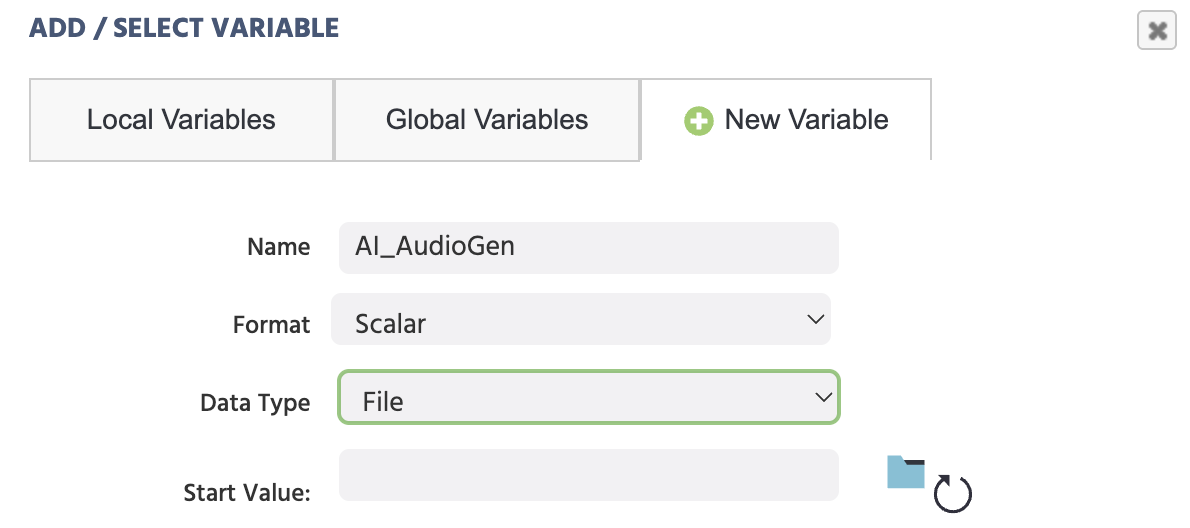

Mit dieser Option können Sie eine generierte Audiodatei angeben, die gespeichert werden soll, und auch angeben, in welcher Variablen sie gespeichert werden soll.

HINWEIS: Beim Zuordnen und Erstellen der jeweiligen Variablen hier, denken Sie daran, den Variablentyp als File auszuwählen, damit die Audiodatei dort gespeichert werden kann.

Nützliche Aktionen

Hinweis: Nachdem Sie den OpenAI Trigger im Ereignissystem ausgewählt haben, haben Sie die Möglichkeit, trigger-spezifische OpenAI-Werte in verschiedenen Aktionen mit dem Wert-Auswahlmenü zu nutzen und zu referenzieren.