Sende an OpenAI Aktion

Übersicht

Die Sende an OpenAI Aktion ermöglicht es Ihnen, Informationen, wie einen Zeichenfolgen-Eingabewert, an OpenAI zu senden. Sie können einen bestimmten Modelltyp angeben, um die Eingabe im Kontext der Text-, Bild- oder Audioerzeugung zu erhalten.

HINWEIS: Damit diese Option verfügbar ist, müssen Sie zunächst Ihren API-Schlüssel im Tab Einstellungen auflisten.

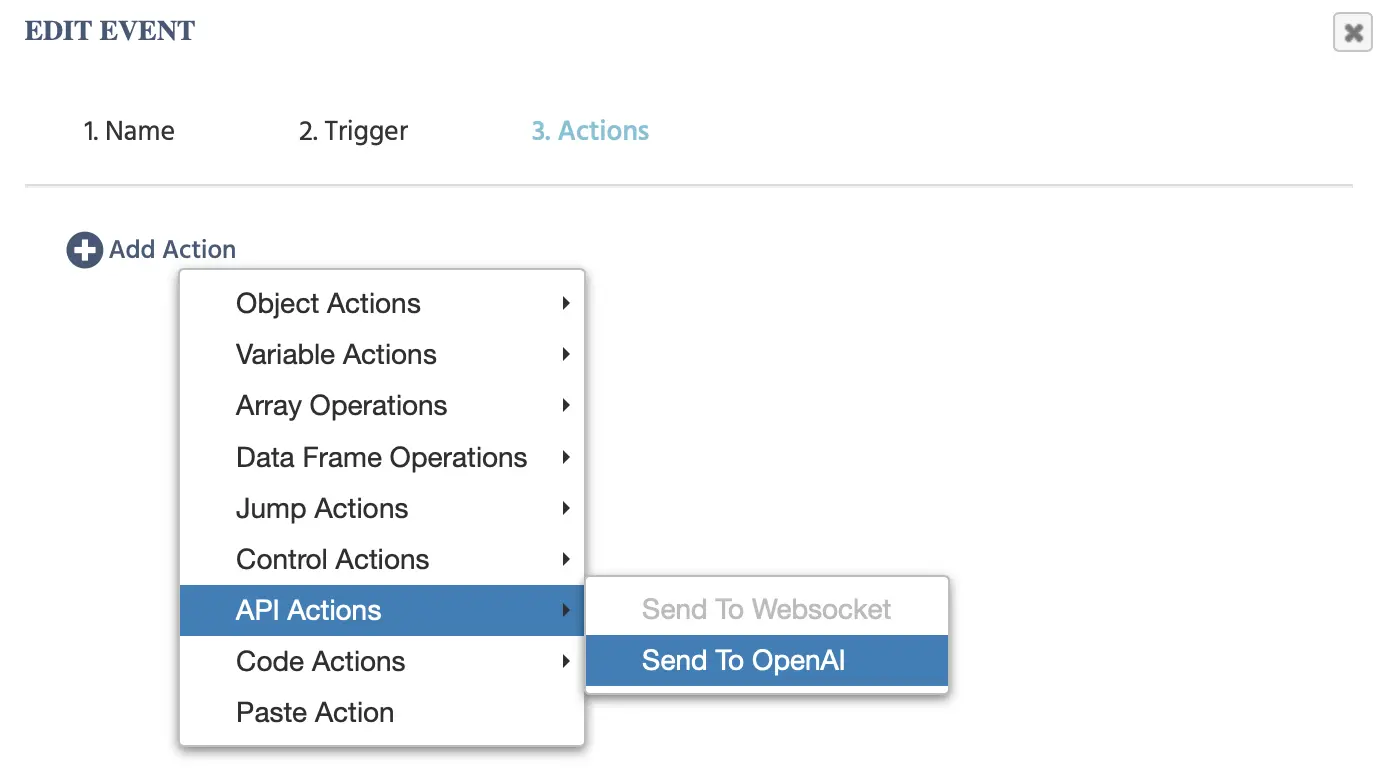

Die folgenden Optionen werden angezeigt, wenn Sie dieses Ereignis anklicken:

Basierend auf der gewählten Modellkategorie,

Modellkategorie

| Modellkategorie | Beschreibung |

|---|---|

ChatGPT | Text-Eingaben an OpenAI senden, um eine textbasierte Antwort zu generieren. |

Bildgenerierung | Text-Eingaben an OpenAI senden, um ein Bild zu generieren. |

Audio erzeugen | Text-Eingaben an OpenAI senden, um Audio zu erzeugen. |

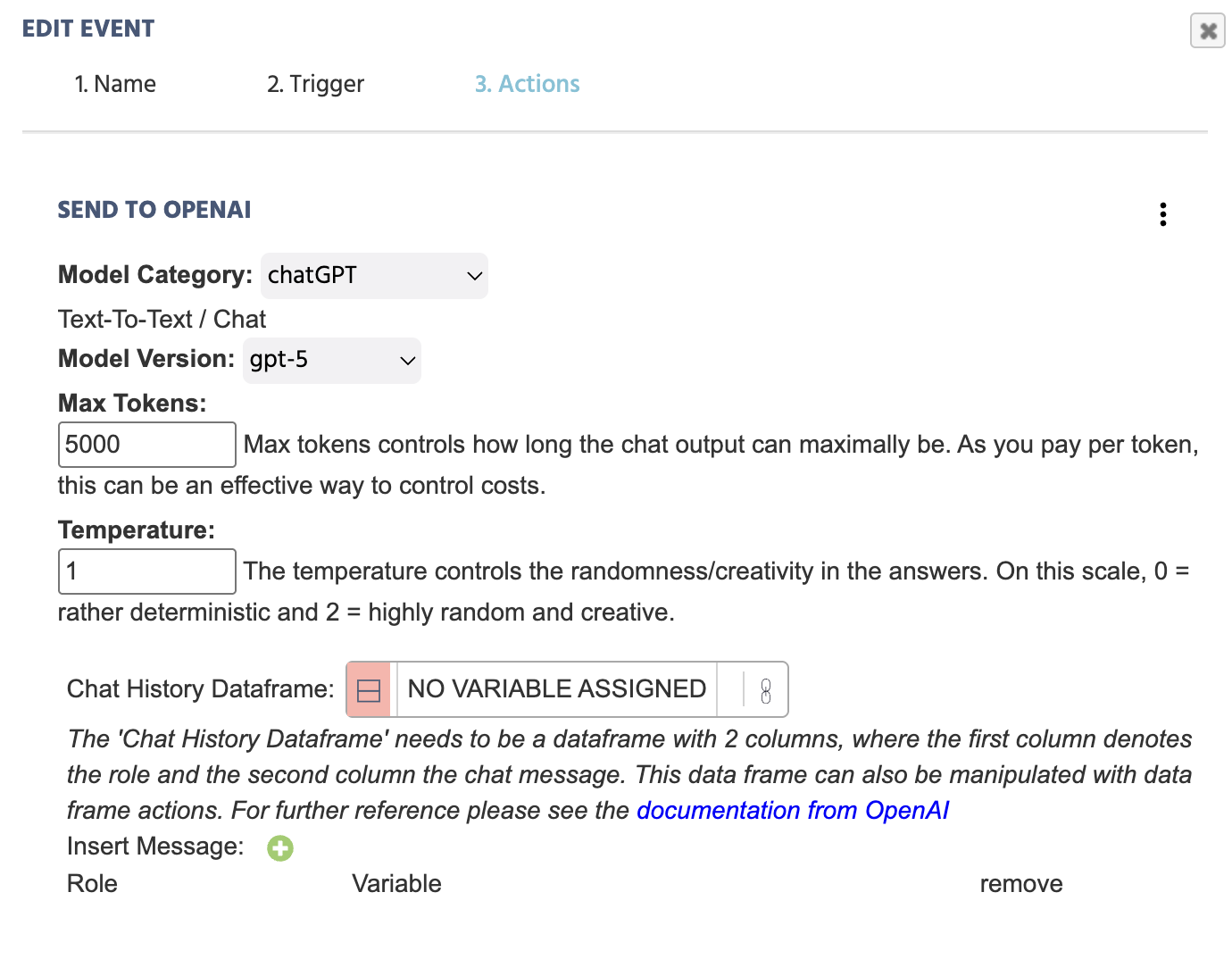

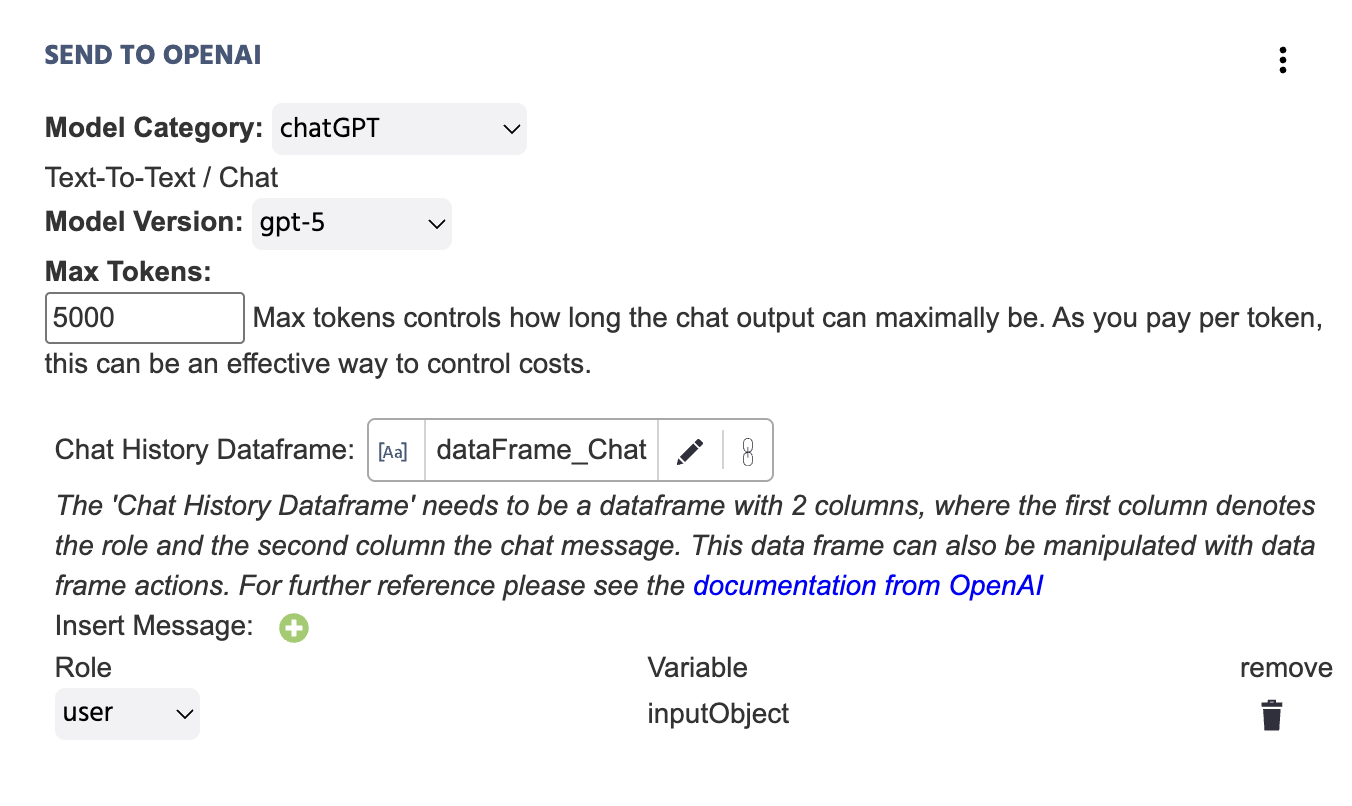

ChatGPT - Modellkategorie

Hier ist ein funktionales Beispiel, wie dieses Ereignis aussieht, wenn alle notwendigen Informationen bereitgestellt werden:

Hier ist eine tiefere Erklärung der Felder, die in der Aktion Sende an OpenAI enthalten sind, mit ChatGPT als Modellkategorie ausgewählt:

| Menüpunkt | Optionen der 'Sende an OpenAI' Aktion - ChatGPT |

|---|---|

Modellkategorie | Gibt die AI-Modellkategorie an, die für die jeweilige Aktion relevant ist. In diesem Fall ist ChatGPT für text-to-text Szenarien ausgewählt. Für die anderen Optionen, wie Bild- oder Audioerzeugung, siehe die Abschnitte unten. |

Modellversion | Gibt die ChatGPT-Version an, die während des Experiments angesprochen werden soll. Verfügbare Optionen sind:

|

Max Tokens | Max Tokens steuert, wie lang die Chat-Ausgabe maximal sein kann. Da Sie pro Token zahlen, kann dies eine effektive Möglichkeit sein, die Kosten zu kontrollieren. |

Temperatur | Die Temperatur steuert die Zufälligkeit/Kreativität in den Antworten. Auf dieser Skala ist 0 = eher deterministisch und 2 = höchst zufällig und kreativ. |

Chatverlauf-Datenrahmen | Link zu einer Datenrahmen-Variable mit zwei Spalten. Die erste Spalte bezeichnet die ‚Rolle‘ und die zweite Spalte die ‚Chat-Nachricht.‘ Die Werte aus der Aktion werden automatisch an den hier verlinkten Datenrahmen angehängt. Der Datenrahmen kann auch mit Datenrahmen-Aktionen bearbeitet werden. Für weitere Hinweise siehe die Dokumentation von OpenAI. |

Nachricht einfügen ‘+’ | Bei Klick darauf erscheint das Variable-Dialogfeld. Sie müssen angeben, welcher ‚Variablen‘-Wert an OpenAI gesendet wird, sowie die ‚Rolle‘ der zugehörigen Nachricht:

|

HINWEIS 1: Siehe auch diese Schritt-für-Schritt-Anleitung, in der wir eine Studie Schritt für Schritt aufbauen, indem wir ChatGPT in eine Studie integrieren und diese Aktion nutzen.

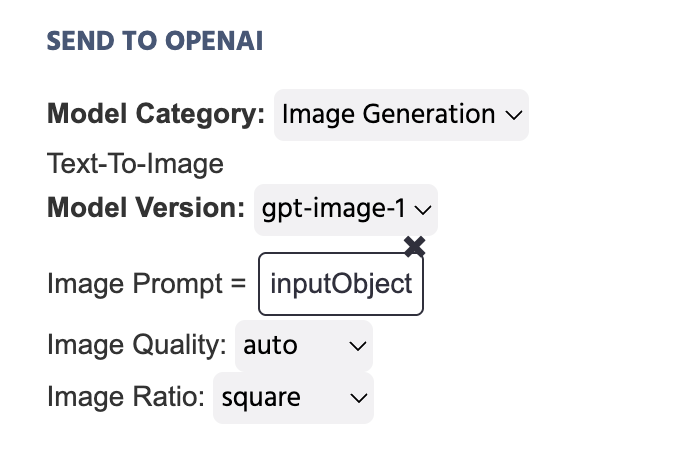

Bildgenerierung - Modellkategorie

Im folgenden Beispiel ist die Variable, die den Text speichert, der in einem Eingabewert geschrieben wurde, so eingestellt, dass sie als Bildaufforderung an OpenAI gesendet wird, als Ergebnis dieser Aktion:

Nützliche Demo: Schauen Sie sich diese Demo an, die Bildgenerierung über den OpenAI Trigger und die Aktion nutzt. Der Teilnehmer wird aufgefordert, eine Aufforderung einzugeben, und diese Aufforderung wird dann verwendet, um ein Bild zu generieren.

Hier ist eine tiefere Erklärung der Felder, die in der Aktion Sende an OpenAI enthalten sind, mit Bildgenerierung als Modellkategorie ausgewählt:

| Menüpunkt | Optionen der 'Sende an OpenAI' Aktion - Bildgenerierung |

|---|---|

Modellkategorie | Gibt die AI-Modellkategorie an, die für die jeweilige Aktion relevant ist. In diesem Fall ist Bildgenerierung für Text-zu-Bild-Szenarien ausgewählt. Für die anderen Optionen, wie Bild- oder Audioerzeugung, siehe die Abschnitte unten. |

Modellversion | Gibt die ChatGPT-Version an, die während des Experiments angesprochen werden soll. Verfügbare Optionen sind:

|

Bildaufforderung | Gibt Ihnen die Möglichkeit, die Aufforderung für das Bild festzulegen, das generiert werden soll. Beliebte Ansätze sind das Festlegen eines Konstanten Wertes wie einer Zeichenfolge oder die Verwendung einer Eingabeobjekt-Variable, die hier verlinkt wird. |

Bildqualität | Fordert Sie auf, die Qualität des Bildes anzugeben, das als Ergebnis der oben verlinkten textbasierten Aufforderung generiert wird. Optionen sind: |

Bildverhältnis | Fordert Sie auf, das Verhältnis des Bildes anzugeben, das generiert wird. |

Bildstil | Im Fall, dass DALL-E-3 als Modellversion ausgewählt wird, erscheint diese Option, um den Bildstil festzulegen. Optionen sind: natürlich und lebendig. |

Audio erzeugen - Modellkategorie

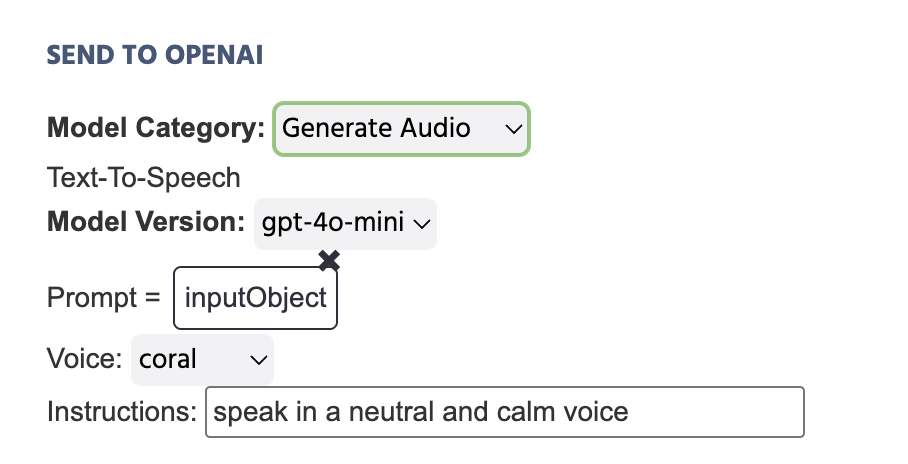

Im folgenden Beispiel ist die Variable, die den Text speichert, der in einem Eingabewert geschrieben wurde, so eingestellt, dass sie als Aufforderung an OpenAI gesendet wird, als Ergebnis dieser Aktion:

Hier ist eine tiefere Erklärung der Felder, die in der Aktion Sende an OpenAI enthalten sind, mit Audio erzeugen als Modellkategorie ausgewählt:

| Menüpunkt | Optionen der 'Sende an OpenAI' Aktion - Audio erzeugen |

|---|---|

Modellkategorie | Gibt die AI-Modellkategorie an, die für die jeweilige Aktion relevant ist. In diesem Fall ist Audio erzeugen für Text-zu-Audio-Szenarien ausgewählt. Für die anderen Optionen, wie Bild- oder Audioerzeugung, siehe die Abschnitte unten. |

Modellversion | Gibt die ChatGPT-Version an, die während des Experiments angesprochen werden soll. Verfügbare Optionen sind:

|

Aufforderung | Gibt Ihnen die Möglichkeit, die Aufforderung für das Audio festzulegen, das generiert werden soll. Beliebte Ansätze sind das Festlegen eines Konstanten Wertes wie einer Zeichenfolge oder die Verwendung einer Eingabeobjekt-Variable, die hier verlinkt wird. |

Stimme | Legen Sie den Stimmton fest, der für das generierte Audio verwendet werden soll. Verfügbare Optionen sind:

|

Anweisungen | Geben Sie weitere Anweisungen ein, damit das generierte Audio Form annimmt, z. B. 'In einer neutralen und ruhigen Stimme sprechen...' |

Nützliche Demo: Schauen Sie sich diese Demo an, die Audioerzeugung über den OpenAI Trigger und die Aktion nutzt. Der gesprochene Text wird über OpenAI generiert und im Kontext des Vorlesens eines Absatzes an die Teilnehmer verwendet, zu dem sie multiple-choice Fragen beantworten müssen.

Wichtige Hinweise

- Da OpenAI täglich weiterentwickelt wird, überprüfen Sie bitte die Dokumentation von OpenAI für weitere Klarstellungen bezüglich des Chats und ziehen Sie in Betracht, durch die Dokumentation für andere Modellkategorien wie Text-zu-Audio zu browsen.